”集成学习的思想“ 的搜索结果

在机器学习的有监督学习算法中,我们的目标是学习出一个稳定的且在各个方面表现都较好的模型,但实际往往不这么完美...集成学习潜在的思想是即便某一个弱分类器得到了错误的预测,其他的弱分类器也可以将错误纠正回来。

11_三种主要集成学习思想简介1

标签: 集成学习

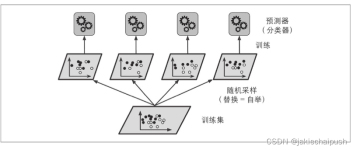

1. 从原始样本集中抽取训练集 2. 每次使个训练集得到个模型,k个训练集共得到k个模型 3. 对分类问题:将上步得到的k个模型采投票的式得到分类结果 1. 是

集成学习(Ensemble Learning)有时也被笼统地称作提升(Boosting)方法,广泛用于分类和回归任务。它最初的思想很简单:使用一些(不同的)方法改变原始训练样本的分布,从而构建多个不同的分类器,并将这些分类器...

文章目录标题集成学习( Ensemble Learning )集成学习的两种思想底层代码实现 标题集成学习( Ensemble Learning ) 定义 集成学习是使用一系列学习器进行学习,并使用某种规则把各个学习结果进行整合从而获得比...

1:集成学习 (Ensemble Learning) 算法的基本思想:将多个分类器组合,从而实现一个预测效果更好的集成分类器。 2: 工作原理:生成多个分类器/模型,各自独立地学习和作出预测。这些预测最后结合成组合预测,因此...

集成学习三大思想集成学习(ensemble learning)boost(迭代优化)bagging(并行独立)stacking(分层优化) 集成学习(ensemble learning) 集成学习就是说将多个 “单个学习器(Individual Learner)”用某种策略...

集成学习算法的思想就是集成多个学习器,并组合它们的预测结果,以形成最终的结论。典型的学习模型组合方法有投票法,专家混合方法,堆叠泛化法与级联法,但这些方法的性能都有待进一步提高。提出了一种新颖的集成...

本文来自于博客园,本文主要使用机器学习算法来将个体机器学习器的结果结合在一起,这个方法就是Stacking,希望对您的...在进行集成学习的时候,我们希望我们的基学习器应该是好而不同,这个思想在后面经常体现。“好”

集成学习 | Bagging思想 | 数据集多样 | 学习器种类单一

随机森林是一种强大的机器学习算法,它通过集成学习的思想将多棵决策树集成起来,形成一片“森林”,以提高整体预测精度并减少过拟合。以下是关于随机森林的简要介绍: 基本概念:随机森林是一个包含多个决策树的...

集成学习(Ensemble Learning)有时也被笼统地称作提升(Boosting)方法,广泛用于分类和回归任务。它最初的思想很简单:使用一些(不同的)方法改变原始训练样本的分布,从而构建多个不同的分类器,并将这些分类器...

参考:ysu老师课件+西瓜书 +期末复习笔记。

1、集成学习(ensemble learning): 1)基础介绍 集成算法,把大大小小的多种分类器融合在一起,共同协作来解决一个问题。充分展示“集体智慧”,“博采众长”思想。集成学习的一般结构,先产生一组...

什么是集成学习? 随机森林 随机森林的生成算法 随机森林的随机性 随机森林的优势 随机森林的参数详解 随机森林模型提高方法 最大特征数(max_features) 子树的数量(n_estimators)最重要的 最大深度...

集成学习的思想就是将若干个学习器(分类器&回归器)组合之后产生一个新学习器; 一般结构如下: 先产生一组“个体学习器”; 再用某种策略将它们结合起来; 最后通过“投票法”或者...

集成学习(Ensemble Learning),通过构建并结合多个学习器来完成学习任务。一般结构是:先产生一组“个体学习器”,再用某种策略将它们结合起来。结合策略主要有平均法、投票法和学习法等。因此,有时也称集成学习...

我们通过一个例子来理解集成学习的概念。假设你是一名电影导演,你依据一个非常重要且有趣的话题创作了一部短片。现在,你想在公开发布前获得影片的初步反馈(评级)。有哪些可行的方法呢?A:可以请一位朋友为电影...

集成学习 (Ensemble Learning)通过构建并结合多个学习器来完成学习任务,有时也被称为多分类器系统( Multi-classifier System)、基于委员会的学习( Committee-based Learning)等。 上图显示出集成学习的一般...

深度学习中的集成学习

标签: cv

在机器学习中的集成学习可以在一定程度上提高预测精度,常见的集成学习方法有Stacking、Bagging和Boosting,同时这些集成方法与具体验证集划分联系紧密。 Dropout Dropout可以作为训练深度神经网络的一种技巧。在每...

推荐文章

- AS 3.1.3连续依赖多个Module,导致访问不到Module中的类_为什么as在一个包下建了多个module,缺无法打开了-程序员宅基地

- Magento 常用插件二-程序员宅基地

- 【连载】【FPGA黑金开发板】Verilog HDL那些事儿--低级建模的资源(六)-程序员宅基地

- R语言实用案例分析-1_r语言案例分析-程序员宅基地

- Java知识体系总结(2024版),这一次带你搞懂Spring代理创建过程-程序员宅基地

- 车辆动力学及在Unity、UE4中的实现_unity 车辆动力学模型-程序员宅基地

- 在vue中使用web3.js开发以太坊dapp_如何使用web3和vue.js创建你的第一个以太坊dapp-程序员宅基地

- Python:太阳花的绘制_绘制一个直径随机的太阳花-程序员宅基地

- Linux常用命令(1)_code=exited, status=0/success-程序员宅基地

- 调用百度地图画圈并标出属于圈内的点位信息_bmap.circle-程序员宅基地