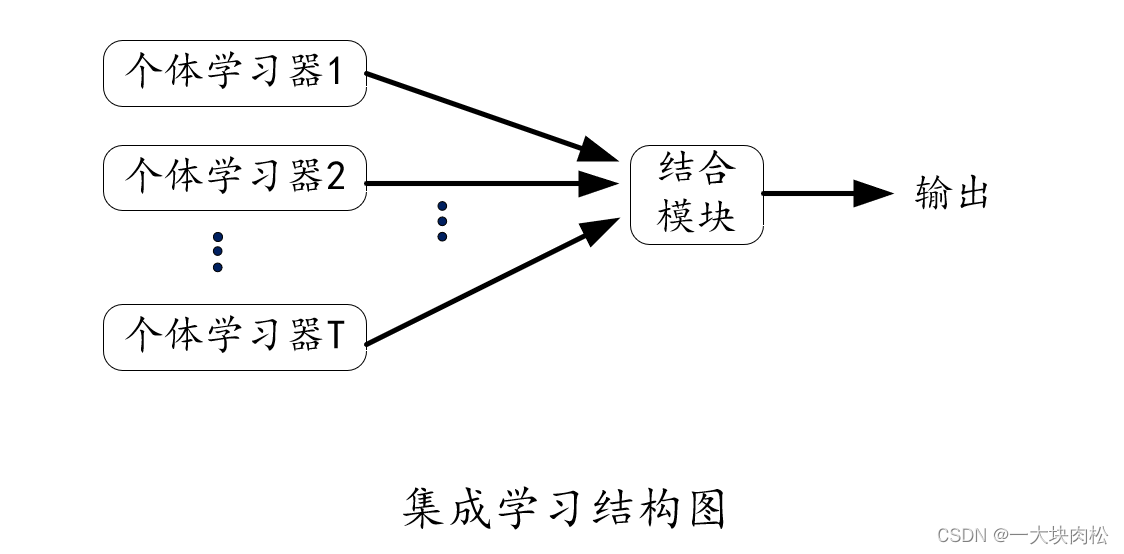

集成学习的基本原理是,训练多个“个体学习器”或者叫基分类器,基学习器。然后用某种策略将它们结合起来,最后可以产生比单一学习器优越得多的性能。 集成学习的基本原理是什么呢?

”集成学习之bagging、boosting及AdaBoost的实现“ 的搜索结果

首先明确一下回归与分类的区别: 分类和回归的区别在于输出变量的类型。 定量输出称为回归,或者说是连续变量预测; 定性输出称为分类,或者说是离散变量预测。...预测明天的气温是多少度,这是一个回归任务;...

转载:https://towardsdatascience.com/ensemble-methods-bagging-boosting-and-stacking-c9214a10a205 作者:Joseph Rocca ... Ensemble methods: bagging, boosting andstacking Introduction “Unity is ...

集成学习简介集成学习(ensemble learning)通过构建并结合多个学习器来完成学习任务。如何产生“好而不同”的个体学习器,是集成学习研究的核心。集成学习的思路是通过合并多个模型来提升机器学习性能,这种方法相...

目录 前言 一、Bagging 1、随机抽样 2、Bagging算法总述 3、随机森林 ...二、Boosting ...1、AdaBoost ...集成学习是机器学习的一个重要分支,利用一种“三个臭皮匠赛过诸葛亮”的思想,通过某种方法将多...

1 集成学习 1.1。何为集成方法? 集成学习是一种机器学习范式。在集成学习中,我们会训练多个模型(通常称为「弱学习器」)解决相同的问题,并将它们结合起来以获得更好的结果。 最重要的假设是:当弱模型被正确...

逻辑回归(LR)与支持向量机(SVM)的区别和联系1、为什么常比较这两个算法2、Bagging3、Boosting4、Bagging与Boosting的区别5、总结 1、为什么常比较这两个算法 Bagging和Boosting都...

假设你去随机问很多人一个很复杂的问题,然后把它们的答案...因此,这个技术就叫做集成学习,一个集成学习算法就叫做集成方法。例如,你可以训练一组决策树分类器,每一个都在一个随机的训练集上。为了去做预测,你...

前言:我们讲到了集成学习按照个体学习器之间是否存在依赖关系可以分为两类,第一个是个体学习器之间不存在强依赖关系,另一类是个体学习器之间存在强依赖关系。后者的代表算法就是是boosting系列算法。本文就对...

实现Bagging算法,训练多个分量分类器,比较分量分类器和最后的总分类器的分类准确率。 Bagging算法: 从大小为n的原始数据集中,分别独立随机地选取n’个样本组成自助数据集,并且将这个过程独立进行许多次,...

一文让你彻底理解 AdaBoost 自适应提升算法 | AdaBoost 的关键要点、基本原理、优缺点和实际应用

随机森林:是一种由决策树构成的bagging集成算法,森林指的是很多棵树,随机指的是样本和特征都随机抽取(有放回的随机抽取,保证森林里面的每棵树都是不那么一样的)。stacking代码:(忽略in[]括号里的顺序,按照...

文章目录集成学习,who are you?多数投票集成学习,要你何用? source:python machine learning 3rd 集成学习是机器学习领域相当重要的一个概念,本篇文章中所关注的集成学习就是使用多个模型,采用同一训练集进行...

Bagging 是从数据的角度得到多样性。Boosting 是一个串行的过程,也就是串行的迭代。Stacking 就是做一个二次学习,我们将 K-NN,Decision Tree 以及 SVM 的预测结果进行一个二次学习,再用一个模型对它的预测结果...

文章目录集成学习BaggingBoosting随机森林(Random Forest,RF)随机森林的推广1、extra trees2、Totally Random Trees Embedding(数据高维映射)3、 Isolation Forest随机森林的优缺点:优点:缺点:Adaboost1、**...

集成学习(Ensemble Learning)就是通过某种策略将多个模型集成起来,通过群体决策来提高决策准确率,所谓“三个臭皮匠顶个诸葛亮”。

Boosting算法: 弱分类器:分类效果差,只是比随机猜测好一点。 强分类器:具有较高的识别率,较好的分类效果。(在百度百科中有提到要能在多项式时间内完成学习) 弱和强更大意义上是相对而言的,并没有严格的...

集成中只包含同种类型的个体学习期称为“同质”的(homogeneous),同质集成中的个体学校称为“基学习器”,相应的学习算法称为“基学习算法”。集成也可包含不同类型的个体学习期,这样的集成是“异质”的...

根据个体学习器的生成方式,目前的集成学习方法大致可...效果能使得最终集成的泛化性能可通过个体学习器之间差异度的增加而进一步提升.Boosting:每个弱分类器都有相应的权重,对于分类误差小的分类器会有更大的权重.

随机森林算法属性 随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每...以决策树为基本模型的bagging在每次bootstrap放回抽样之后,产生一棵决策树,抽多少样本就生成多少...

Boosting 方法1、概述2、原理2.1 加法模型2.2 前向分布算法3、系列算法3.1 AdaBoost 算法 1、概述 \quad \quadBoosting是一种用来提高弱分类算法准确度的方法(集成学习方法),通过反复修改训练数据的权值分布,...

算法原理:Bagging、Boosting(AdaBoost)原理与公式推导 算法步骤: import numpy as np import seaborn as sns sns.set_style('white') from sklearn.tree import Dec...

推荐文章

- Android 编译so文件 MP4V2_android下编译mp4v2-程序员宅基地

- 通讯录Contact_02_contact文件内容-程序员宅基地

- Qt笔记(四十二)之QZXing的编译 配置 使用_qzxingfilterrunnable error:-程序员宅基地

- 关于画图软件Dia打开程序始终为英文界面的问题-程序员宅基地

- OpenCV从入门到精通实战(二)——文档OCR识别(tesseract)-程序员宅基地

- 详解avcodec_receive_packet 11_avcodec_receive_packet eagain-程序员宅基地

- OpenGL SuperBible 7th源码编译记录_superbible7-media github-程序员宅基地

- Wireshark简单使用-程序员宅基地

- MXNet 粗糙的使用指南_iou loss mxnet-程序员宅基地

- iOS对ipa包进行代码混淆《二》 ---代码混淆_ipa包混淆-程序员宅基地