”集成学习之bagging、boosting及AdaBoost的实现“ 的搜索结果

可以通过聚集多个分类器的预测结果提高分类器的分类准确率,这一方法称为集成(Ensemble)学习或分类器组合(Classifier Combination),该方法由训练数据构建一组基分类器(Base Classifier),然后通过对每个基...

6、【集成学习】之bagging、boosting、stacking浅析

# 1. 引言 ## 1.1 介绍集成学习的概念 集成学习(Ensemble Learning)是指通过构建并结合多个学习器来完成学习任务的一种机器学习方法。相比于单一的学习器,集成...常见的集成学习方法包括Bagging算法和Boosting算法

Bagging、随机森林、Boosting、GBDT

什么是集成学习? 将多个分类方法聚集在一起,以提高分类的准确率。 (这些算法可以是不同的算法,也可以是相同的算法) 集成学习法由训练数据构建一组基分类器,然后通过对所有基分类器的预测投票进行分类。 ...

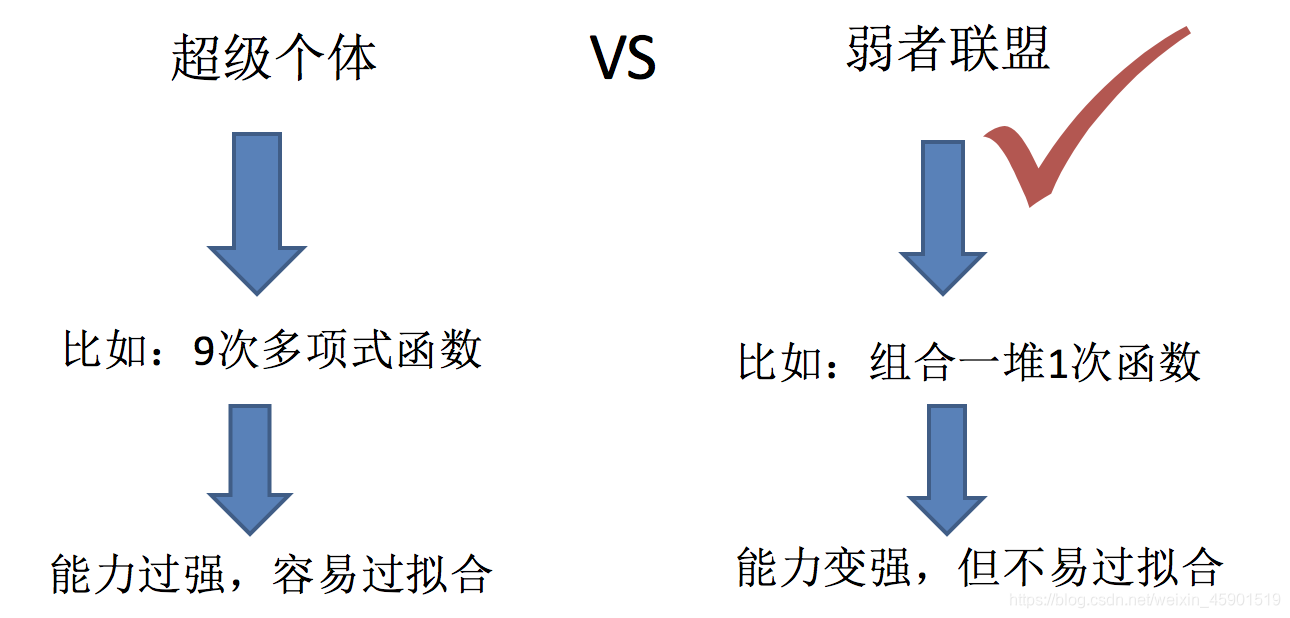

boosting算法是一类将弱学习器提升为强学习器的集成学习算法,它通过改变训练样本的权值,学习多个分类器,并将这些分类器进行线性组合,提高泛化性能。

Bagging和Boosting的区别: 1)样本选择上: Bagging:训练集是在原始集中有放回选取的,从原始集中选出的各轮训练集之间是独立的。 Boosting:每一轮的训练集不变,只是训练集中每个样例在分类器中的权重发生...

文章目录集成学习1.... Bagging & Pasting2.1 包外评估2.2 Random Patches 和 随机子空间3. 随机森林3.1 极端随机树3.2 特征重要性参考资料 相关文章: 机器学习 | 目录 ...监督学习 | 集成学习之AdaBoost原...

Boosting算法 AdaBoost 与Bagging算法比较

Ensemble! 很清晰的入门课,极其清晰。李老师要是能多讲一点就好了~

Boosting, 也称为增强学习或提升法,是一种重要的集成学习技术, 能够将预测精度仅比随机猜度略高的弱学习器增强为预测精度高的强学习器,这在直接构造强学习器非常困难的情况下,为学习算法的设计提供了一种有效的...

集成学习源于弱可学习和强可学习的等价性证明。一个概念是弱可学习的是指存在多项式时间内的学习算法能够学习它,且学习的正确率略高于随机猜测;一个概念强可学习是指存在多项式时间内的学习算法能够学习它,且学习...

Bagging和Boosting 概念及区别 Bagging和Boosting都是将已有的分类或回归算法通过一定方式组合起来,形成一个性能更加强大的分类器,更准确的说这是一种分类算法的组装方法。即将弱分类器组装成强分类器的方法。 ...

一、集成学习 集成学习是将若干个学习器(分类器、回归器)组合之后产生一个新的学习器。 一般来说,集成学习可以分为三类: bagging:减少方差,即防止过拟合 boosting:减少偏差,即提高训练样本正确率 ...

博主在之前的博客当中介绍过利用决策树处理回归和分类的问题(基于CART的回归和分类任务),决策... 集成学习(Ensemble Learning) 在机器学习算法中具有较高的准去率,不足之处就是模型的训练过程可能比较复杂,效...

bootstrap、bagging、boosting和adaboost是机器学习中几种常用的重采样方法。其中bootstrap重采样方法主要用于统计量的估计,bagging、boosting 和 adaboost方法则主要用于多个子分类器的组合。 一、bootstrap:估计...

在集成算法中,主要有两种方法,即Bagging和Boosting。简单理解, Bagging算法: 就是独立地建立多个模型,各个模型之间互不干扰,然后将多个模型预测结果做平均,作为最终预测结果; Boosting算法: 有序的、依赖的...

集成学习是集合多个弱监督模型,通过一定的结合策略,得到一个更好更全面的强监督模型的过程.潜在的思想是即使某一个弱分类器得到了错误的预测,其他的弱分类器也可以将错误纠正回来

跟我一起机器学习系列文章将首发于公众号:月来客栈,欢迎文末扫码关注! 1 引例 通过前面几篇文章的学习,我们已经了解了机器学习中的多种分类和回归模型。那现在有一个问题就是,哪一个模型最好呢?以分类任务为例...

机器学习 - 集成方法(Bagging VS. Boosting 以及随机森林) 集成方法 Bagging Bagging 分类: Bagging 的预测: Boosting 两个定义 两个问题 Bagging VS. Boosting 随机森林 AdaBoost AdaBoost 算法过程 训练误差界...

Boosting Boosting策略在上一篇中有提到过,这里再说一遍。 Boosting策略的核心思想就是对错误分类的样本投入更大的关注。采用的是加法模型和向前分步算法,... Boosting, 也称为增强学习或提升法,是一种重要...

集成学习之Boosting 1.boosting集成原理 1.1 什么是boosting 随着学习的积累从弱到强 简而言之:每新加入一个弱学习器,整体能力就会得到提升 代表算法:Adaboost,GBDT,XGBoost 1.2 实现过程: 1.训练第...

推荐文章

- Android RIL框架分析-程序员宅基地

- Python编程基础:第六节 math包的基础使用Math Functions_ps math function-程序员宅基地

- canal异常 Could not find first log file name in binary log index file_canal could not find first log file name in binary-程序员宅基地

- 【练习】生成10个1到20之间的不重复的随机数并降序输出-程序员宅基地

- linux系统扩展名大全,Linux系统文件扩展名学习-程序员宅基地

- WPF TabControl 滚动选项卡_wpf 使用tabcontrol如何给切换的页面增加滚动条-程序员宅基地

- Apache Jmeter常用插件下载及安装及软硬件性能指标_jmeter插件下载-程序员宅基地

- SpringBoot 2.X整合Mybatis_springboot2.1.5整合mybatis不需要配置mapper-locations-程序员宅基地

- ios刷android8.0,颤抖吧 iOS, Android 8.0正式发布!-程序员宅基地

- 【halcon】C# halcon 内存暴增_halcon 读二维码占内存-程序员宅基地