”集成学习之bagging、boosting及AdaBoost的实现“ 的搜索结果

AdaBoost通过迭代添加弱学习器(与真实分类器仅轻微相关的分类器)来创建强学习器(与真实分类器相关性良好的分类器)。在每轮训练期间,都会向集成中添加一个新的弱学习器,并调整权重向量以重点关注前几轮中错误...

Bagging和Boosting是机器学习领域中常用的集成学习方法。Bagging通过对数据集进行有放回抽样,构建多个基学习器,然后将它们的预测结果进行平均或投票来得出最终结果;Boosting则是一种迭代的提升方法,每一轮都会...

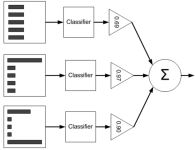

Bagging、Boosting和AdaBoost(Adaptive Boosting)都是Ensemble learning的方法。集成学习其实就是有很多个分类器,概念就是三个臭皮匠,顶过诸葛亮。 ensemble learning的基本条件是每个分类器之间要有差异,并且每...

Bagging(自举聚合):Bagging是一种并行式的集成学习方法,它通过随机抽样生成多个训练子集,然后基于每个子集训练一个弱学习器,最后将这些弱学习器的预测结果进行平均或投票来得到最终的预测结果。Bagging的典型...

Bagging和Boosting:集成学习对抗过拟合 作者:禅与计算机程序设计艺术 1. 背景介绍 机器学习模型在实际应用中常常会面临过拟合的问题,导致模型在训练集上表现良好但在测试集或新数据上性能下降。集成学习是一种有效...

Bagging (Bootstrap Aggregation)Pruning Classification is one of the simplest classification algorithms. It works just like if-then. However, when aggregating a lot of prunnings we are able to create a...

群体的智慧常常优于单个个体的决策。正所谓,“三个臭皮匠顶个诸葛亮”,集成学习的思路正是如此。...以上就是今天的学习内容,本文仅仅简单介绍了集成学习的思想,详细了解了AdaBoost算法的设计过程。

集成学习Bagging ,Boosting等介绍的PPT。集成方法是构建一种对单个分类器进行集成的学习算法,将各分类器的分类结果以一定的方式集成起来实现对新数据点进行分类,其中单个分类器是独立的且不要求分类精度很高。...

集成学习bagging与boosting关键技术与区别介绍

集成学习是一种机器学习范式,旨在通过构建并组合多个模型来解决单一预测问题。它基于一个简单却强大的理念:“三个臭皮匠,顶一个诸葛亮”,或者用西方的谚语来说,“两个头脑胜过一个头脑”。在集成学习的背景下,...

1,Bagging Bagging即套袋法,其算法过程如下: 1,从原始样本集中抽取训练集。每轮从原始样本集中使用Bootstraping的方法(有放回)抽取n个训练样本(在训练集中,有些样本可能被多次抽取到,而有些样本可能一次都...

代表:Adaboost(Adaptive boosting)公式推导可见《机器学习》P174优点:泛化错误率低,易编码,可以应用在大部分分类器上,无参数调整缺点

Boosting思想:Adaboost(分类)更改x权重 | GBDT(分类/回归)算法更改y值

在这一章中,我们将介绍集成学习方法中的Boosting与Bagging在R语言中的应用。首先,我们将探讨研究背景与意义,然后对集成学习进行概述。随后,我们会简要介绍Boosting与Bagging的基本概念,并阐明研究本文的目的与...

集成学习 1.导言 一个形象的比喻:“三个臭皮匠赛过诸葛亮!” 假设输入x\boldsymbol{{x}}x和输出y\boldsymbol{{y}}y之间的真实关系为:y=h(x)\boldsymbol{{y}}=h(\boldsymbol{{x}})y=h(x).对于M\boldsymbol{{M}}M个...

集成学习方法-Boosting-Adaboost Adaboost算法: AdaBoost,英文为‘Adaptive Boosting’,它的自适应在于:1. 样本权重的自适应学习 2. 模型系数的自适应学习。相对于RF算法,Adaboost更加专注于偏差,它可以降低基...

有关集成学习AdaBoost和Gradient Boosting的简单理解

1、决策树与集成学习的关系 根据python3 决策树(ID3、C4.5、CART)原理详细说明与公式推导可知: 决策树容易解释,可以处理离散和连续值,对输入变量的单调转换不敏感(因为分割点是基于数据点的排序),执行自动...

文章目录集成学习介绍Bagging方法随机森林(random forests)Boosting方法Adaboost集成学习的结合策略 集成学习介绍 集成学习通过构建并组合一系列的个体学习器(基学习器或组件学习器)来完成学习任务。 个体...

集成学习中的boosting主要有两类,Adaboost和gradient boosting,而GBDT和XGboost都是gradient boosting的具体应用。 Boosting和bagging相比,主要的区别在于基学习器之间是相互影响的,是串行训练的,具体来说,...

1 什么是集成学习 集成学习通过建⽴⼏个模型来解决单⼀预测问题。 它的⼯作原理是⽣成多个分类器...3 集成学习中Boosting 和 Bagging 只要单分类器的表现不太差, 集成学习的结果总是要好于单分类器的 4 Bag...

集成学习就是组合这里的多个弱监督模型以期得到一个更好更全面的强监督模型,集成学习潜在的思想是即便某一个弱分类器得到了错误的预测,其他的弱分类器也可以将错误纠正回来。 Baggging 和Boosting都是模型融合的...

推荐文章

- Process finished with exit code -1073740791 (0xC0000409)定位错误原因-程序员宅基地

- LiDAR-BEVMTN:自动驾驶中的实时激光雷达鸟瞰图多任务感知网络-程序员宅基地

- Maven build 报错:No goals have been specified for this build_maven build报错-程序员宅基地

- PE结构->【基址重定位】-程序员宅基地

- 基于跳表实现的轻量级KV存储引擎 项目总结_跳表作为存储引擎-程序员宅基地

- 易安卓E4A弹出提示代码_e4a 弹出提示-程序员宅基地

- 第4章 分布式数据库HBase(又是一篇呕心力作,一文详讲HBase)_15、bigtable 分布式数据库采用文件存储方式为 共三种。 ,hbase分布式数据库采用文件存-程序员宅基地

- 国产操作系统产业_操作系统产业分类-程序员宅基地

- 【细胞分割】阈值+边缘+形态学+种子点+主动轮廓图像分割【含GUI Matlab源码 1477期】_细胞核分割中阈值分割-程序员宅基地

- [转载]框架Hibernate Validator 简介-程序员宅基地