1 集成学习概述 集成学习(Ensemble Learning)是一种能在各种的机器学习任务上提高准确率的强有力技术,其通过组合多个基分类器(base classifier)来完成学习任务。基分类器一般采用的是弱可学习(weakly ...

”集成学习“ 的搜索结果

一、集成学习 集成学习(Ensemble learning)是使用一系列学习器进行学习,并使用某种规则把各个学习结果进行整合,从而获得比单个学习器显著优越的泛化性能。它不是一种单独的机器学习算法,而更像是一种优化策略...

最近入手了周志华老师的《集成学习:基础与算法》一书,对书中介绍的目前常用的三大集成方法Boosting、Bagging、Stacking进行了学习。这篇博客主要是对这三大集成思想的一些总结,不涉及理论层面的推导。

集成学习(ensemble learning)通过构建并结合多个学习器来完成学习任务,有时也被称为多分类器系统(multi-classifier system)。

集成学习之Stacking详解

标签: 机器学习

stacking 就是当用初始训练数据学习出若干个基学习器后,将这几个学习器的预测结果作为新的训练集,来学习一个新的学习器。 最初的想法是: 1:用数据集D来训练h1,h2,h3…, 2:用这些训练出来的初级学习器在数据集...

集成学习Stacking(模型融合) 简介 在数据竞赛中有这一种方法,它是一个强有力的武器,只要能够善于使用,它就是无往不利,无坚不摧的那把利剑,更是被称为数据竞赛胜出的杀手锏。它通过构建并结合多个弱学习器...

集成学习是构建一组基学习器,并将它们综合作为最终的模型,在很多集成学习模型中,对基学习器的要求很低,集成学习适用于机器学习的几乎所有的领域:1、回归2、分类3、推荐4、排序 集成学习有效的原因多样的基学习...

集成学习是一种通过将多个模型的预测结果进行组合来提高模型性能的方法。常见的集成学习方法包括投票法、平均法和堆叠法等。通过结合多个模型的预测,集成学习可以减小模型的方差,提高模型的泛化能力。

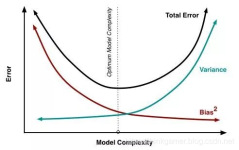

一、集成学习法 在机器学习的有监督学习算法中,我们的目标是学习出一个稳定的且在各个方面表现都较好的模型,但实际情况往往不这么理想,有时我们只能得到多个有偏好的模型(弱监督模型,在某些方面表现的比较好)...

集成学习,分为两大类。如果基模型都是通过一个基础算法生成的同类型的学习器,这叫同质集成。有同质集成就有异质集成,就是把不同类型的算法集成在一起。—— Stacking 和 Blending,就是两种异质集成学习方法。

什么是集成学习算法?2. 集成学习主要有哪几种框架?3. 简单介绍一下bagging,常用bagging算法有哪些?4. 简单介绍一下boosting,常用boosting算法有哪些?5. boosting思想的数学表达式是什么?6. 简单介绍一下...

集成学习基本了解1. 为什么需要集成学习2. Bagging 基本概念: 给定我们一个原始训练样本集,我们将其拆分为多份,分别对每份样本集建立一个分类器(一般是弱分类器),分类器之间相互独立,最后再将...

本章为Bagging与神经网络结合的方式

上篇主要介绍了鼎鼎大名的EM算法,从算法思想到数学公式推导(边际似然引入隐变量,Jensen不等式简化求导),EM算法实际上可以理解为一种坐标下降法,首先固定一个变量,...本篇将继续讨论下一类经典算法–集成学习。

类不平衡学习的集成学习方法

标签: 集成学习

给定一个分类问题,大多数的机器学习方法都会做出如下的假设: >每一个类具有相同的误分类代价; > 不同类的数据分布式平衡的; > 算法的目标是最大化分类的准确率(Accuracy)。 然而,许多实际应用...

集成学习 本文主要介绍 voting (投票学习器) bagging / pasting 3.随机森林 boosting 1.集成学习概述 1.1 概述 集成学习通过结合多个单一学习器,并聚合其预测结果的学习任务,也可以称作多分类系统等,下面是集成...

集成学习(Ensemble Learning) 集成学习是机器学习中一个非常重要且热门的分支,是用多个弱分类器构成一个强分类器,其哲学思想是“三个臭皮匠赛过诸葛亮”。一般的弱分类器可以由决策树,神经网络,贝叶斯分类...

原帖:阿里云云栖社区: ... 关于dropout的分析,可以...《深度学习网络大杀器之Dropout——深入解析Dropout》 1.引言 随着2012年Hiton的文章《ImageNet classification with deep convolutional neural networks》...

Bagging简介Bagging是并行式集成学习的最著名代表,名字是由Bootstrap AGGregatING缩写而来,看到Bootstrap我们就会联想到boostrap的随机模拟法和它对应的样本获取方式,它是基于自助采样法(Boostrap sampleing),...

一、机器学习概述 1. 什么是机器学习? 机器学习是从人工智能中产生的一个重要学科分支,是实现智能化的关键。 经典定义:利用经验改善系统自身的性能。 研究内容:在计算机上从数据中产生“模型”,用于对新的...

集成学习 ensemble 机器学习 集成方法 boosting PCA bagging boosting stacking

很好很实用的C语言集成学习环境! 适合初级学习者使用,欢迎大家下载!

推荐文章

- 【Java进阶】线程池之无限队列 - 使用工厂类Executors.newFixedThreadPool(n) ,创建无限队列线程池_线程池无限队列-程序员宅基地

- python 之路,致那些年,我们依然没搞明白的编码-程序员宅基地

- 国二报C语言,国二C语言.doc-程序员宅基地

- FTP快速搭建-程序员宅基地

- [原创]我的WCF之旅(7):面向服务架构(SOA)和面向对象编程(OOP)的结合——如何实现Service Contract的继承_servicecontract using-程序员宅基地

- openmediavault(OMV) (18)云相册(2)photoprism-程序员宅基地

- VS2017使用protobuf动态链接库的编译错误问题_vs2017运行不了protobuf项目-程序员宅基地

- idea右键项目没有出现git选项、idea工具栏没有Git快捷图标_idea 右键没有git-程序员宅基地

- m3u8索引文件介绍_69嗉媂x.m3u8-程序员宅基地

- 2021 泰迪杯 A 题_第十二届泰迪杯数据挖掘竞赛a题论文-程序员宅基地