Tranasformer实战系列课程旨在帮助同学们快速掌握当下Ai领域最火算法模型,通俗讲解transformer架构在NLP与CV领域的核心算法并基于真是数据集与实际任务展开项目实战。课程主要包括四大模块:1.算法讲解;2.论文分析...

”transformer“ 的搜索结果

21世纪电源网,邵革良先生的培训视频用到的反激电源设计工具。邵先生是TI的电源专家,精通反激电源变压器设计讲解的很详细,有不小的参考价值。

整个网络是,先经过两层卷积,然后将featuremap切割成四份,分别经过四个并行的transformer(heads可以自己设置),再将 上诉结果concat,再经过一个transformer,然后就是一层层地decoder。 主要调试main.py、...

尚未训练过据说可以达到5.6 非干净数据也就是有噪声数据

我们定义了一个简单的Transformer模型,包括嵌入层(embedding layer)、位置编码(positional encoding)、编码器(encoder)和全连接层(fully connected layer)。TransformerModel类表示整个模型,...

transformer时间序列预测

Transformer visualization via dictionary learning: contextualized embedding as a linear superposition of transformer factors

another_transformer_page_view PageTransformer的抖动。来自叉使用非常简单import 'package:another_transformer_page_view/another_transformer_page_view.dart';...new TransformerPageView(loop: true,...

重新定义视频变压器(用途为RESNET基地)transformer_v1.py更像是真正的变压器,transformer.py更真实到什么纸通告用法: from transformer_v1 import Semi_Transformer model = Semi_Transformer(num_classes=num...

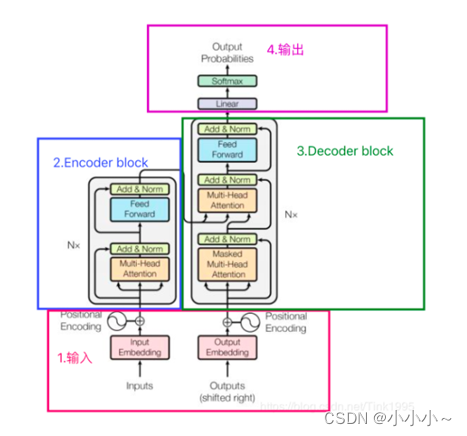

Transformer 多头注意力层 基于位置的前馈网络 Add and Norm 位置编码 多层感知机注意力 测试 译码器 解码器 训练 Transformer CNNs 易于并行化,却不适合捕捉变长序列内的依赖关系。 RNNs 适合捕捉长距离变长序列的...

高温高压变压器Pytorch实现的 ,这是Transformer-XL的变体,具有用于远程语言建模的压缩内存。 我还将其与的想法相结合,该在残留相交处添加了门控。 记忆和门控可能是协同的,并导致语言建模和强化学习方面的进一步...

改用Transpiled class-transformer // import "reflect-metadata" into your main fileimport "https://esm.sh/reflect-metadata" ; // you need to --allow-envimport { Expose , plainToClass } from ...

Transformer 模型作为一种新颖的神经网络结构,在自然语言处理领域取得了巨大的成功。通过深入理解其原理、应用场景和实践指南,我们可以更好地应用 Transformer 模型解决实际问题,推动自然语言处理技术的发展。...

simulation is done to see the magnetizing current of transformer

Transformer-Tensorflow2 用于分类的Transformer架构要求:Tensorflow 2.0

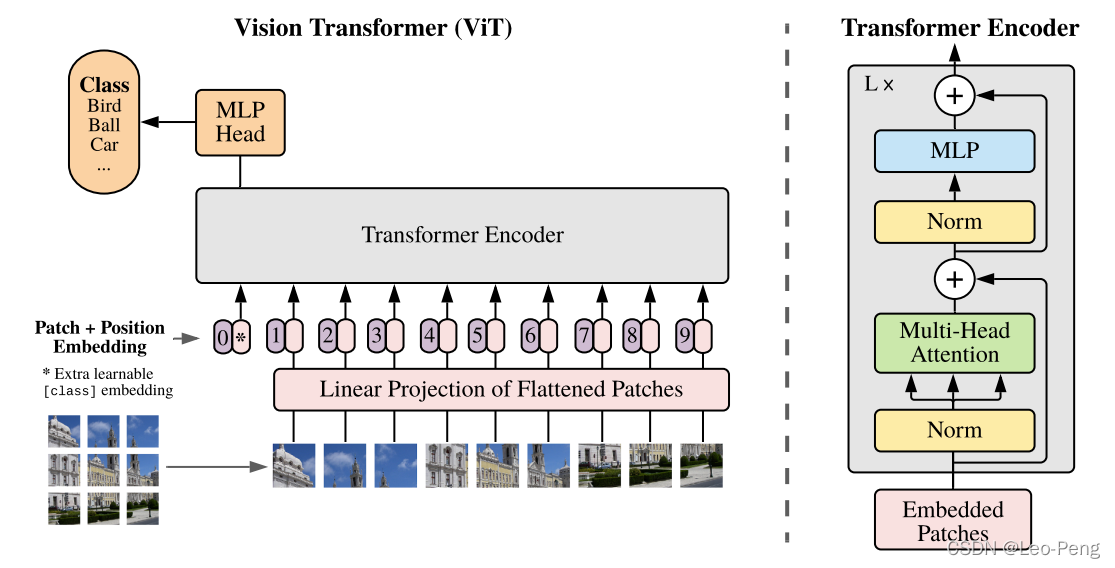

vision transformer self-supervised

Transformer模型结构超级详细的解读,一文带你了解什么是Transformer,小白入门必看!

#DSSM模型适用于个性化推荐,无新用户冷启动,要求至少有一条阅读记录

资源分类:Python库 所属语言:Python 使用前提:需要解压 资源全名:En_transformer-0.5.3-py3-none-any.whl 资源来源:官方 安装方法:https://lanzao.blog.csdn.net/article/details/101784059

使用 Keras 和 tensorflow 实现的Transformer模型.zip

一文带你学会encoder-decoder框架

为何Transformer在计算机视觉中如此受欢迎?.pdf

推荐文章

- Android技术交流群-程序员宅基地

- 数据竞赛专题 | 从赛题理解到竞赛入门基础-程序员宅基地

- 软件工程工程伦理案例分析_案例工具及其范围| 软件工程-程序员宅基地

- 2021-04-09_ive格式可以用3dmax打开吗-程序员宅基地

- innovus: 如何写出floorplan和power信息_dcg innovus-程序员宅基地

- 计算机毕业设计springbootVue的应急救援物资管理系统pzg1h9【附源码+数据库+部署+LW】-程序员宅基地

- 微信小程序设置单个页面自定义头部加背景图-程序员宅基地

- Android 注解处理器使用攻略_incremental-annotation-processor-support-程序员宅基地

- 【幻兽帕鲁】服务器一键部署,5分钟快速上手_win10本地部署 幻兽帕鲁服务器部署-程序员宅基地

- AI 绘画Stable Diffusion 研究(二)sd模型ControlNet1.1 介绍与安装_sd contronet模型-程序员宅基地