”spark安装“ 的搜索结果

大致顺序是这样,仅供参考,欢迎指正!命令行不能直接复制,所以出错的可能比较大。 第一关: mkdir /app ...tar -zxvf scala-2.12.7.tgz -C /app ...第2关:安装与配置Spark开发环境 mkdir /

在ubuntu环境中搭建spark基础框架

Impala-Kudu-HBase-Spark安装文档

下面讲一下linux上安装spark,以?Standalone Mode 安装?1)首先安装JDK?下载JDK:jdk-7u79-linux-x64.tar.gz ?,版本是1.7以上都行,解压 tar -zxvf?jdk-7u79-linux-x64.tar.gz ??然后配置 ~/.bashrc?增加export JAVA...

Spark安装使用教程PDF

标签: Spark

Spark安装使用教程PDF

第1章 安装VMWare Workstation 10;第2章 VMware 10安装CentOS 6;第3章 CentOS 6安装Hadoop;第4章 安装部署Spark;第5章Spark上机操作;第6章 开发Spark分布式程序

spark环境安装 第一关 mkdir /app //创建 app 目录 cd /opt tar -zxvf scala-2.12.7.tgz -C /app vi /etc/profile #set scala SCALA_HOME=/app/scala-2.12.7 export PATH=$PATH:$SCALA_HOME/bin source /etc/...

Spark安装配置和基础编程 重要知识点: Spark是一个开源的可应用于大规模数据处理的分布式计算框架,该框架可以独立安装使用,也可以和Hadoop一起安装使用。为了让Spark可以使用HDFS存取数据,本实验采取和Hadoop...

实验八、Spark的安装与使用.doc

spark安装文档.zip

大数据环境搭建——>Spark安装配置

Spark安装出错问题

标签: spark

spark 安装详细步骤

标签: spark安装

1.下载 spark 安装包 选择自己Hadoop对应的版本,不然会不兼容 spark下载链接 2.解压 tar -zvxf spark.2.3 3.删除安装包,修改解压后的文件名字 rm -rf 安装包名 mv spark-2.3.4-bin-hadoop2.7 spark 4. 配置...

java 环境搭建 Scala环境搭建 Hadoop环境搭建 Maven环境搭建 python3环境部署 Spark源码编译及部署 一、java环境搭建 二、Scala环境搭建 三、 Hadoop环境搭建 ...

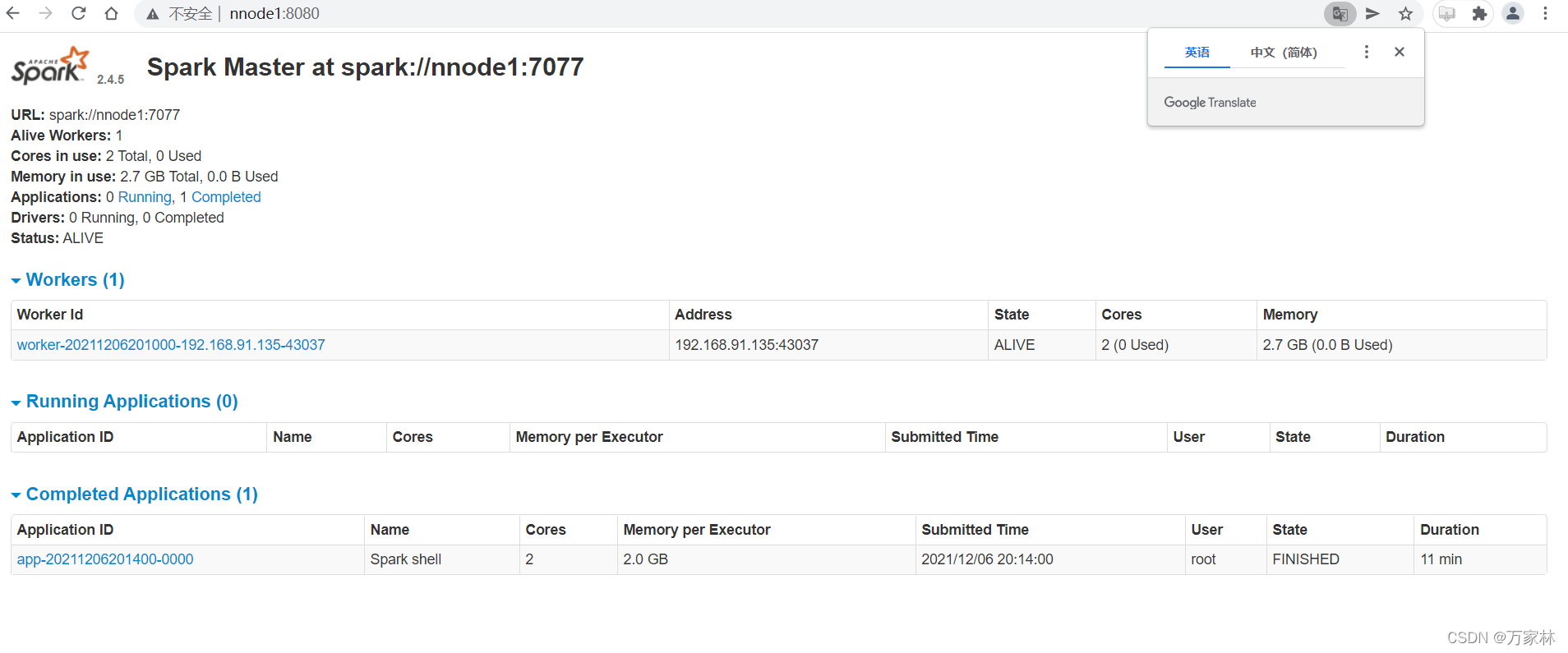

SparkSpark运行模式Spark环境搭建上传 & 解压解压目录说明启动spark-shell初体验-读取HDFS文件Standalone集群模式集群角色介绍集群规划修改配置并分发通过scp 命令将配置文件分发到其他机器上集群启动和停止测试...

1. 解压Spark安装包 2. 配置Spark环境变量 2. 修改 spark-env.sh 文件,完成以下设置: 1. 设置运行master进程的节点, e

使用安装包版本: spark-2.0.0-bin-hadoop2.6 下载地址 https://spark.apache.org/ Spark概述 Apache Spark是一个快速的通用集群计算系统。...一、安装 1、解压 [root@master app] # tar -zxvf spark-2.0.0-b...

spark安装步骤详解;spark安装步骤详解;spark安装步骤详解;spark安装步骤详解;spark安装步骤详解;spark安装步骤详解;spark安装步骤详解;spark安装步骤详解

hdfs+spark安装指南

标签: 安装指南

hdfs+spark安装指南

最后一章学习 Spark安装与配置以下是实验步骤 一、在Windows下下载Scala和Spark 官网下载安装Spark:spark-2.4.2-bin-hadoop2.7.tgz 官网下载安装Scala: https://www.scala-lang.org/download/ 二、将压缩包从...

在我们学习时更多的是用伪分布式环境来进行操作,以下就是伪分布式Hadoop+Spark安装与配置 centos:7.4 jdk:1.8 hadoop:2.7.2 scala:2.12.13 spark:3.0.1 1、配置虚拟机 下载centos-7,安装虚拟机 1、配置静态...

为了避免MapReduce框架中多次读写磁盘带来的消耗,以及更充分地利用内存,加州大学伯克利分校的AMP Lab提出了一种新的、开源的、类Hadoop MapReduce的内存编程模型Spark。一、spark是什么?Spark是一个基于内存的...

推荐文章

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地

- Python 攻克移动开发失败!_beeware-程序员宅基地

- Swift4.0_Timer 的基本使用_swift timer 暂停-程序员宅基地

- 元素三大等待-程序员宅基地

- Java软件工程师职位分析_java岗位分析-程序员宅基地

- Java:Unreachable code的解决方法_java unreachable code-程序员宅基地

- 标签data-*自定义属性值和根据data属性值查找对应标签_如何根据data-*属性获取对应的标签对象-程序员宅基地