”spark安装“ 的搜索结果

Spark开发环境搭建.pdf

Apache Spark 是一个快速的通用集群计算系统。它提供了Java, Scala, Python ,R 四种编程语言的 API 编程接口和基于 DAG 图执行的优化引擎。它还支持一系列丰富的高级工具:处理结构化数据的 Spark SQL,用于机器...

spark安装1

标签: spark hadoop

2、易用性Spark支持Java、Python和Scala的API,还支持超过80种高级算法,使用户可以快速构建不同的应用 3、通用性Spark提供了统一的解决

spark编程基础

1) spark-submit提交任务。2) spark-shell,单词计数。

Spark安装教程

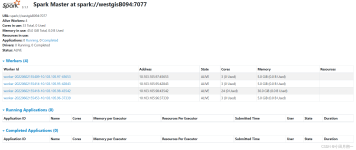

安装Spark之前,需要安装JDK、Hadoop、Scala。显示上面的正常运行界面,表示本地的spark环境已搭建完成!环境变量Path添加条目%SCALA_HOME%\bin。为了验证Scala是否安装成功,开启一个新的cmd窗口。环境变量Path添加...

为了避免MapReduce框架中多次读写磁盘带来的消耗,以及更充分地利用内存,加州大学伯克利分校的AMP Lab提出了一种新的、开源的、类Hadoop MapReduce的内存编程模型Spark。一、spark是什么?Spark是一个基于内存的...

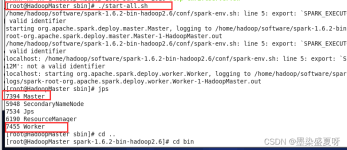

添加以下内容,/bigdata/hadoop就是hadoop的...用xftp上传Linux虚拟机,上传目录/bigdata(可修改)注:此安装教程基于hadoop3集群版本。这是一个求Π的示例程序,输出如下。打开spark shell终端。修改spark配置文件。

准备至少2台虚拟机,装好linux系统,我装的是Ubuntu20.04。

Apache Spark是一个基于内存的分布式计算框架,它提供了高效、强大的数据处理和分析能力。与传统的Hadoop MapReduce相比,Spark的主要优势在于其能够将数据集缓存在内存中,从而大大减少了磁盘I/O操作,提高了数据...

在浏览器中打开的Jupyter Notebook界面中,...核对安装步骤与使用的python环境都是正确的,但是还在报错。解决:先打开anaconda,从界面中启动pycharm。首先确保已经在终端中激活了Conda环境。解决:哪里不行注释哪里。

目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新**官网下载地址:...安装的验证,直接在命令行输入。然后在path上也改。装完同样环境变量设置。

首先来聊聊什么是Spark?为什么现在那么多人都用Spark? Spark简介: Spark是一种通用的大数据计算框架,是基于**RDD(弹性分布式数据集)**的一种计算模型。那到底是什么呢?可能很多人还不是太理解,通俗讲就是可以...

Spark安装文档以及介绍

标签: spark

Spark的介绍,spark的安装配置,认识spark,spark的特点

-检查每个任务正使用的物理内存量,如果任务超出分配值,则将其杀掉,默认是true -->--检查每个任务正使用的虚拟内存量,如果任务超出分配值,则将...tar –zxvf spark包名 –C /opt/module。若显示版本号则配置成功。

但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

适合大数据分析初学者,安装大数据分析工具spark,并用python语言测试(保姆级教学)。

JAVA+HADOOP+SPARK安装

修改配置文件 在spark下的conf目录打开env vim spark-env.sh。录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新**source /etc/...查看spark是否安装成功。

但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

完整的spark安装指南,包含shell命令和步骤图片。

主要介绍了centOS7下Spark安装配置教程详解,非常不错,具有一定的参考借鉴价值,需要的朋友可以参考下

推荐文章

- 【Java进阶】线程池之无限队列 - 使用工厂类Executors.newFixedThreadPool(n) ,创建无限队列线程池_线程池无限队列-程序员宅基地

- python 之路,致那些年,我们依然没搞明白的编码-程序员宅基地

- 国二报C语言,国二C语言.doc-程序员宅基地

- FTP快速搭建-程序员宅基地

- [原创]我的WCF之旅(7):面向服务架构(SOA)和面向对象编程(OOP)的结合——如何实现Service Contract的继承_servicecontract using-程序员宅基地

- openmediavault(OMV) (18)云相册(2)photoprism-程序员宅基地

- VS2017使用protobuf动态链接库的编译错误问题_vs2017运行不了protobuf项目-程序员宅基地

- idea右键项目没有出现git选项、idea工具栏没有Git快捷图标_idea 右键没有git-程序员宅基地

- m3u8索引文件介绍_69嗉媂x.m3u8-程序员宅基地

- 2021 泰迪杯 A 题_第十二届泰迪杯数据挖掘竞赛a题论文-程序员宅基地