”Transformer“ 的搜索结果

使用Pytorch实现Attention is all you need

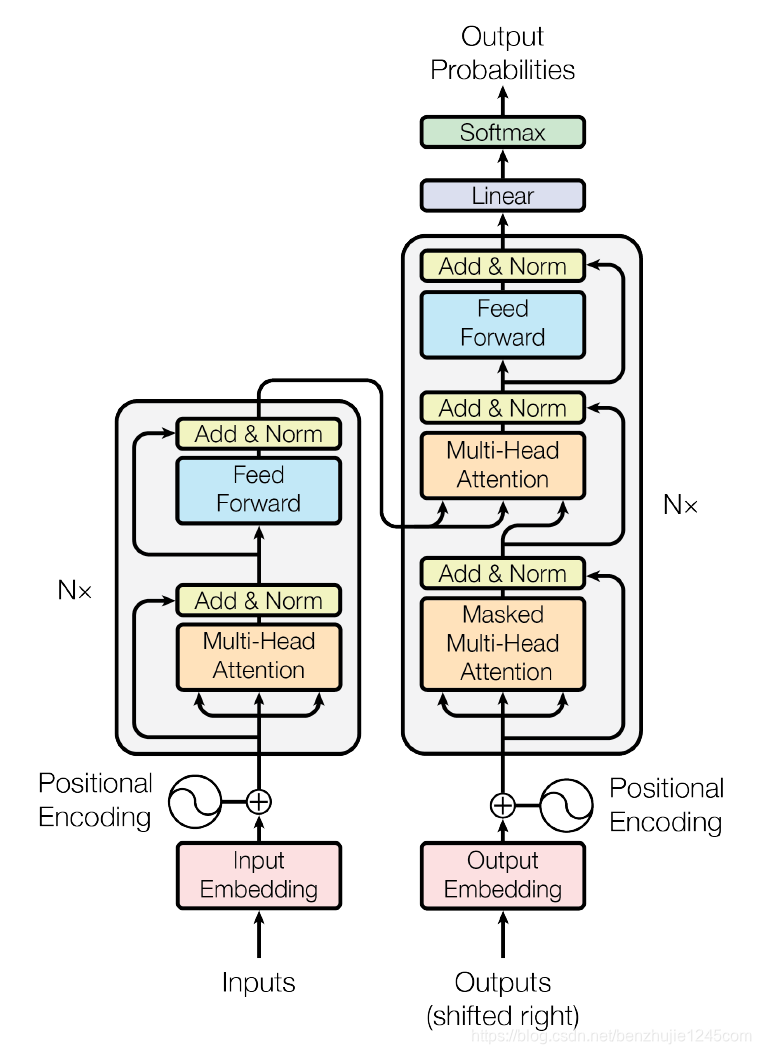

Transformer在Goole的一篇论文被提出,为了方便实现调用TransformerGoogle还开源了一个第三方库,基于TensorFlow的,一个NLP的社区研究者贡献了一个Torch版本的支持:。这里,我想用一些方便理解的方式来一步一步...

多头注意力机制是transformer的主要创新点,它摒弃了传统卷积神经网络和神经网络的思想,通过 Scaled Dot-Product Attention实现了信息交互,但一次性使用scle dot attention对计算机计算和信息交互而言效果并不好,...

Transformer设计中一个具有挑战性的问题是,全局自注意力的计算成本非常高,而局部自注意力通常会限制每个词向量的交互域。为了解决这个问题,作者提出了CSWin Transformer。CSWin Transformer 在常见的视觉任务上...

transformer强大到什么程度呢,基本是17年之后绝大部分有影响力模型的基础架构都基于的transformer(比如,有200来个,包括且不限于基于decode的GPT、基于encode的BERT、基于encode-decode的T5等等)通过博客内的这篇...

【计算机视觉 | Transformer】魔改Transformer!9种提速又提效的模型优化方案分享!

之前的文章好多人蹲代码 这就上传了

Transformer 在之前的章节中,我们已经介绍了主流的神经网络架构如卷积神经网络(CNNs)和循环神经网络(RNNs)。让我们进行一些回顾: CNNs 易于并行化,却不适合捕捉变长序列内的依赖关系。 RNNs 适合捕捉长距离...

transformer

标签: Kotlin

transformer

Transformer 模型的实现(最初来自 )应用于时间序列(由提供支持)。 变压器型号 Transformer 是基于注意力的神经网络,旨在解决 NLP 任务。 它们的主要特点是: 特征向量维度的线性复杂度; 序列计算的并行化,...

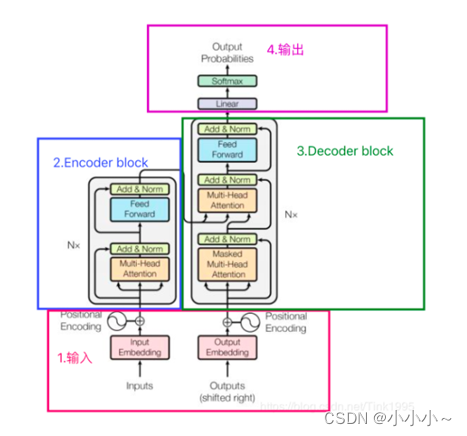

1.Transformer背景介绍 2.Transfromer整体架构 3.Transformer输入部分 4.Transfromer的编码器 5.Transfromer的解码器 6.Transformer输出部分 7.Transfromer其他部分 1.GPT-1 和 Bert 2.GPT-2 3.GPT-3 Transformer在...

基于TCN-Transformer模型的时间序列预测(Python完整源码),可以用于做光伏发电功率预测,风速预测,风力发电功率预测,负荷预测等,python程序 python代码,pytorch 基于TCN-Transformer模型的时间序列预测...

本例提取了植物幼苗数据集中的部分数据做数据集,数据集共有12种类别,演示如何使用timm版本的Swin Transformer图像分类模型实现分类任务已经对验证集得分的统计,本文实现了多个GPU并行训练。 通过本文你和学到: ...

Swin Transformer 实现图像分类完整代码,拿走即用,路径都是相对路径不用改,自带预训练权重和数据集,不懂可以交流,随随便便参加比赛项目,毕业设计等。

ViT的全文翻译,结构同原文保持一致。 1.全文翻译的markdown原文件 2.全文翻译的PDF 3..ViT的原文 4.知识点总结的博客http://t.csdn.cn/PLzkf 逐字逐句翻译Vision in Transformer

本篇讲解试图从最浅显的角度来让大家了解大语言模型的基础模型,Transformer模型,不涉及到任何数学公式和神经网络的基础知识。适合对于初学者的科普。

本文介绍了一种称为Swin Transformer的新型视觉变形金刚,它可以用作计算机视觉的通用骨干。 在两个领域之间的差异,例如视觉实体规模的巨大差异以及与文字中的单词相比,图像中像素的高分辨率,带来了使...

基于变压器的场景文本识别(Transformer-STR) 我的基于场景文本识别(STR)新方法的PyTorch实现。 我改编了由设计的四阶段STR框架,并替换了Pred. 变压器的舞台。 配备了Transformer,此方法在CUTE80上优于上述...

使用Transformer模型应用于多通道ECG分类任务上,压缩包里有数据集(双通道ECG信号,处理后的信号每个通道长度为152,类别数为2,训练及测试样本数为100)、数据处理代码和模型代码,可以直接运行,准确率达到85%。...

自然语言处理中的Transformer模型真正改变了我们处理文本数据的方式。Transformer是最近自然语言处理发展的幕后推手,包括Google的BERT。了解Transformer的工作原理、它如何与语言建模、序列到序列建模相关,以及它...

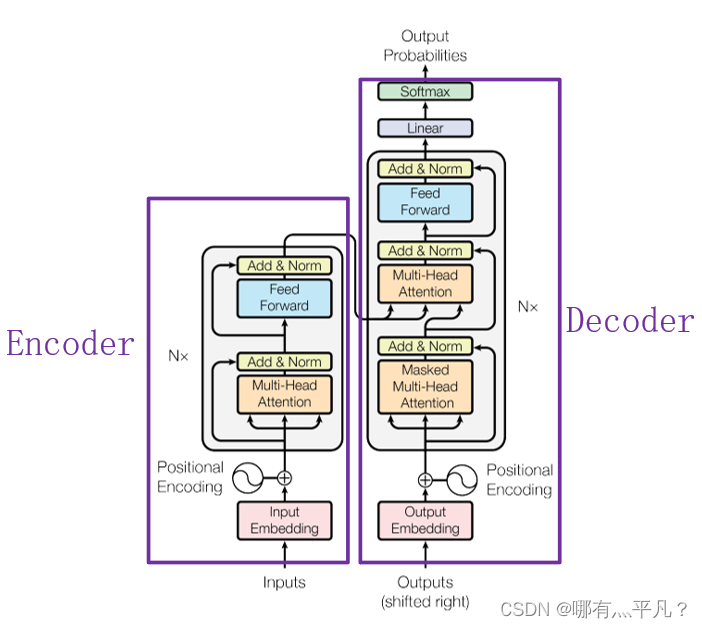

图一就是Transformer模型的框架,不过这里的encoder和decoder不再是RNN结构,拆开来看,细节如图二:原始论文里,作者设置了6层encoder与6层decoder结构。至于为什么是6,这就是一个超参数而已,可以根据实际情况...

安装$ pip install point-transformer-pytorch用法import torchfrom point_transformer_pytorch import PointTransformerLayerattn = PointTransformerLayer ( dim = 128 , pos_mlp_hidden_dim = 64 , attn_mlp_...

基于Transformer的长时间序列代码汇总(Autoformer,PEDformer,Informer,Crossformer,ETSformer,Pyraformer,TimesNet,Reformer,DLinear等15个时间序列预测,分类算法代码汇总)含电力,ETT油温,外汇,病情,交通车...

推荐文章

- 记录CentOS7 Linux下安装MySQL8_适合正式环境_干货满满(超详细,默认开启了开机自启动,设置表名忽略大小写,提供详细配置,创建非root专属远程连接用户)_centos7安装mysql8-程序员宅基地

- python 读取grib \grib2-程序员宅基地

- Kimi Chat,不仅仅是聊天!深度剖析Kimi Chat 5大使用场景!-程序员宅基地

- Datawhale-集成学习-学习笔记Day4-Adaboost-程序员宅基地

- TexStudio配置以及解决无法Build&View_texstudio 无法启动 build & view:pdflatex:"d:/data/texl-程序员宅基地

- 用户空间访问I2C设备驱动-程序员宅基地

- 人脸识别算法初次了解-程序员宅基地

- maven的pom文件学习-程序员宅基地

- wamp mysql 没有启动,WAMP中mysql服务突然无法启动 解决方法-程序员宅基地

- 《树莓派Python编程入门与实战(第2版)》——3.7 创建Python脚本-程序员宅基地