文章目录需求:有时候有些网站的反爬对cookies有限制,批量获取cookies代码使用说明:主要你要对于你需要批量获取cookies的网址多个url搜集,我自己找了100多个地址吧,放到detail_url.txt文件里面,你把这个替换成...

”批量获取指定网址cookies“ 的搜索结果

软件不限行业,指定格式的详情页网址均能有效提取。 更新摘要: 1,登录方式以及程序界面做了调整,程序更加稳定快捷 2,增加拍拍产品详情页图片批量下载的功能 3,修复速卖通产品提取的一处BUG 4,增加配置文件,...

仅使用Python3.x自带的标准库:urllib.request、re、os,及简单的IO操作

最近一直再研究python,所以打算用python模拟登录来试试,直接上代码,亲测可用,省事又省力。因为一个网站被恶意留言,1000多条,后台一条一条删...python通过使用浏览器获取的cookie,模拟登录网站批量删除新闻。...

具体下载的版本根据自己的谷歌浏览器版本进行下载,然后将下载好的驱动webdriver放到自己python解释器同级目录中即可,下载地址http://npm.taobao.org/mirrors/chromedriver/此代码可用于华为服务器批量巡检,...

3.增加总集数(自动获取最多集数的地址库):{maxz_num} 4.增加相关影片集{maxz_related} 5.增加下载模块 6.增加上下集数标签,让用户播放更方便 7.增加顶踩模块,用户体验 8.优化生成HTML的速度 9.增加专题模块(暂没开放...

SQLMap sqlmap是一款SQL注入漏洞测试工具,支持MySQL, Oracle,PostgreSQL, Microsoft SQL Server, Microsoft Access, IBM DB2, ...常用参数注意:必须指定至少一个目标-u#指定URL,必须使用双引号包含url--...

In [3]:进群:548377875 即可获取数十套PDF哦!import requestsimport json打开地理空间数据云的登录页面。按F12进入开发者工具台,在Element栏目,我们找到登录的表单,可以看到提交到后台有6个参数:csrfmiddlewa....

A05-批量注册组件

标签: javascript 前端 vue.js

个人主页:Silence Lamb 基于Vue3.2+ElementPlus+Vuex+Ajax+JS

python m4a 音频

@百度分享链接批量转存到百度网盘 百度分享链接批量转存到百度网盘 最近拿到一批百度分享的链接,想要批量保存到自己的网盘里,于是就写了一段代码自动实现,在这里分享给大家。 我把百度转存的代码放出来,取...

php给数组赋值的实例方法数组就是一个键值对组成的语言结构,键类似于酒店的房间号,值类似于酒店房间里存储的东西。如果你去某个酒店住店,服务员会告诉你房间号是多少,具体房间里有存储了什么,那就需要根据房间...

Cookies包含了存储在用户浏览器中的信息,如会话状态、用户首选项等。当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些...

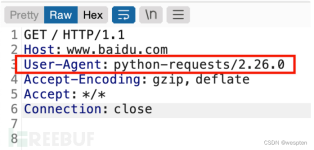

使用 Python 批量爬取 WebShell还在用爬虫爬一些简单的数据?太没意思了!我们来用爬虫爬 WebShell!0. 引子前些天访问一个平时经常访问的网站,意外的发现这个站出了问题,首页变成了 phpStudy 探针 2014,大概是...

package com.http; import java.io.BufferedReader; import java.io.InputStreamReader; import java.net.URL; import java.net.URLConnection; import java.util.List; import java.util.Map;... * @Author d...

批量下载yum仓库rpm包欢迎使用wget工具语法格式: wget [参数]参考 欢迎使用wget工具 wget命令用来从指定的URL下载文件。 wget非常稳定,它在带宽很窄的情况下和不稳定网络中有很强的适应性,如果是由于网络的...

功能:批量读取excel百度链接转存到自己的百度网盘指定目录 第一步:获取自己百度网盘的BDUSS,STOKEN,bdstoken这三个数据,方法:登录百度网盘,通过浏览器开发者模式获取这些信息,参考如下 第二步:把参数填入...

官网 http://simpletest.org/Php单元测试工具simpletest一 总览什么是simpletestsimpletest是一个用PHP编写的开源项目这个项目的目的是使PHP开发者方便快捷的对自己的代码进行单元测试所有代码用PHP编写开发者可以...

Js与cookie

curl 'https://signon.jgi.doe.gov/signon/create' --data-urlencode 'login=*****' --data-urlencode 'password=*****' -c cookies > /dev/null # ****处修改为账号与密码 下载所有文件的列表 curl '...

Phytozome官网提供了四种数据下载方式,前三种为网页操作模式,在此不多介绍,在此主要介绍第四种 官方manual Download with Cart Download with web UI Download with Globus service Download with API ...

Python网络爬虫与文本数据分析(视频课)常见的爬虫都是采集文本数据,如果待采集的是很多个文件,如何批量下载?今天我们以巨潮资讯网 http://www.cninfo.com.cn 为...

简介 ... CALIPSO数据定制以及简单介绍 可以在前期博客中找到简介,看这篇博文前建议首先阅读。 上篇CALIPSO下载方法。 wget下载方法 wget for windows 安装 GNU Wget是一个在网络上进行下载的简单而强大的自由软件,其...

使用示例:例1:抓取页面到指定文件,如果有乱码可以使用iconv转码# curl -o baidu.html www.baidu.com# curl –s –o baidu.html www.baidu.com |iconv -f utf-8 #减少输出信息例2:模拟浏览器头(user-agent)# curl...

wget 命令wget命令用来从指定的URL下载文件。wget非常稳定,它在带宽很窄的情况下和不稳定网络中有很强的适应性,如果是由于网络的原因下载失败,wget会不断的尝试,直到整个文件下载完毕。如果是服务器打断下载过程...

在Python项目开发实战中,网络爬虫批量采集股票数据并保存到Excel文件,是一种高效、定制化的数据获取与管理方式。本节将详细阐述该过程的特点、步骤、优化策略以及应用价值。

推荐文章

- 航空航天数值分析matlab算法,数值分析 matlab-程序员宅基地

- Zookeeper权限管理与Quota管理_zookeeper ip 和quota ip-程序员宅基地

- ocr数据集:图片数据集_ocr 图片集-程序员宅基地

- python识图自动化_聊聊 Python 自动化截图的一些经验-程序员宅基地

- python语言的关键字是什么_Python语言的关键字有哪些特点?关键字列举-程序员宅基地

- pandas数据处理之groupby的常用用法_pandas怎么处理groupby的结果-程序员宅基地

- 第一次参赛获Java B组国二,给蓝桥杯Beginners的6700字保姆级经验分享。_蓝桥杯java组经验贴-程序员宅基地

- 二叉链表——构建与输出_构建一个用二叉链表存储一个公司组织机构的相关数据的程序,假设该公司的下属-程序员宅基地

- 详解支持向量机(SVM)算法与代码实现_3. 软间隔和核svm分别实现一个识别task。代码-程序员宅基地

- C#使用TreeView控件实现的二叉树泛型节点类 BinaryTreeNode<T>泛型二叉树类BinaryTree<T>及其方法_c# treeview 树状节点-程序员宅基地