CEEMDAN +组合预测模型(BiLSTM-Attention + ARIMA)_github ceemdan-cnn-bilstm-attention-程序员宅基地

目录

2.1 划分数据集,按照8:2划分训练集和测试集, 然后再按照前7后4划分分量数据

3 基于CEEMADN的BiLSTM-Attention模型预测

3.2 定义CEEMDAN-BiLSTM-Attention预测模型

4.1 数据加载,训练数据、测试数据分组,四个分量,划分四个数据集

往期精彩内容:

时序预测:LSTM、ARIMA、Holt-Winters、SARIMA模型的分析与比较-程序员宅基地

风速预测(二)基于Pytorch的EMD-LSTM模型-程序员宅基地

风速预测(三)EMD-LSTM-Attention模型-程序员宅基地

风速预测(四)基于Pytorch的EMD-Transformer模型-程序员宅基地

风速预测(五)基于Pytorch的EMD-CNN-LSTM模型-程序员宅基地

风速预测(六)基于Pytorch的EMD-CNN-GRU并行模型-程序员宅基地

风速预测(七)VMD-CNN-BiLSTM预测模型-程序员宅基地

CEEMDAN +组合预测模型(BiLSTM-Attention + ARIMA)-程序员宅基地

CEEMDAN +组合预测模型(CNN-LSTM + ARIMA)-程序员宅基地

CEEMDAN +组合预测模型(Transformer - BiLSTM+ ARIMA)-程序员宅基地

CEEMDAN +组合预测模型(CNN-Transformer + ARIMA)-程序员宅基地

多特征变量序列预测(一)——CNN-LSTM风速预测模型-程序员宅基地

多特征变量序列预测(二)——CNN-LSTM-Attention风速预测模型-程序员宅基地

多特征变量序列预测(三)——CNN-Transformer风速预测模型-程序员宅基地

多特征变量序列预测(四)Transformer-BiLSTM风速预测模型-程序员宅基地

多特征变量序列预测(五) CEEMDAN+CNN-LSTM风速预测模型-程序员宅基地

多特征变量序列预测(六) CEEMDAN+CNN-Transformer风速预测模型-程序员宅基地

多特征变量序列预测(七) CEEMDAN+Transformer-BiLSTM预测模型-程序员宅基地

基于麻雀优化算法SSA的CEEMDAN-BiLSTM-Attention的预测模型-程序员宅基地

基于麻雀优化算法SSA的CEEMDAN-Transformer-BiGRU预测模型-程序员宅基地

多特征变量序列预测(八)基于麻雀优化算法的CEEMDAN-SSA-BiLSTM预测模型-程序员宅基地

多特征变量序列预测(九)基于麻雀优化算法的CEEMDAN-SSA-BiGRU-Attention预测模型-程序员宅基地

多特征变量序列预测(10)基于麻雀优化算法的CEEMDAN-SSA-Transformer-BiLSTM预测模型-程序员宅基地

VMD + CEEMDAN 二次分解,BiLSTM-Attention预测模型-程序员宅基地

基于麻雀优化算法SSA的预测模型——代码全家桶-程序员宅基地

前言

本文基于前期介绍的风速数据(文末附数据集),介绍一种综合应用完备集合经验模态分解CEEMDAN与混合预测模型(BiLSTM-Attention + ARIMA)的方法,以提高时间序列数据的预测性能。该方法的核心是使用CEEMDAN算法对时间序列进行分解,接着利用BiLSTM-Attention模型和ARIMA模型对分解后的数据进行建模,最终通过集成方法结合两者的预测结果。

风速数据集的详细介绍可以参考下文:

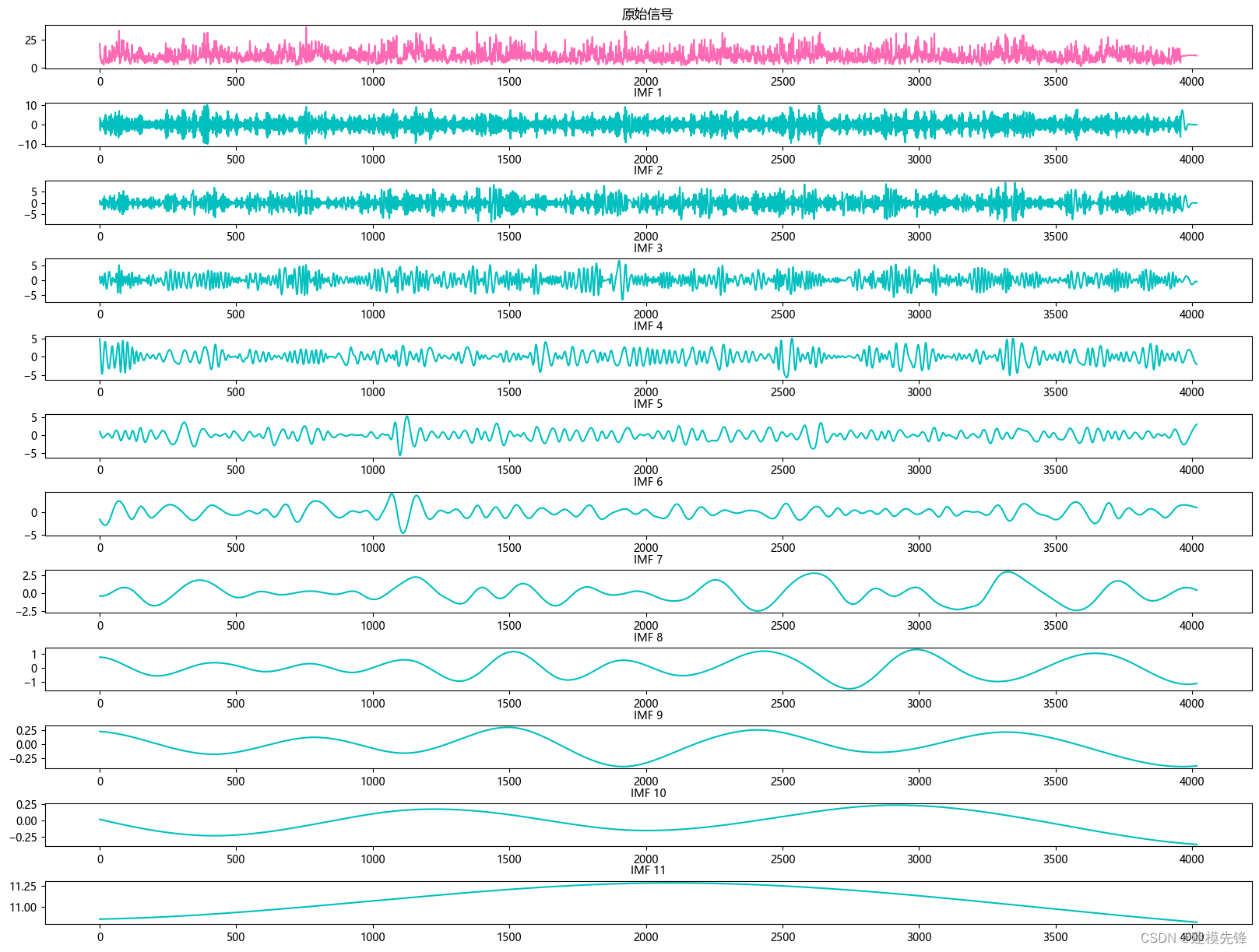

1 风速数据CEEMDAN分解与可视化

1.1 导入数据

1.2 CEEMDAN分解

根据分解结果看,CEEMDAN一共分解出11个分量,我们大致把前7个高频分量作为BiLSTM-Attention模型的输入进行预测,后4个低频分量作为ARIMA模型的输入进行预测

2 数据集制作与预处理

2.1 划分数据集,按照8:2划分训练集和测试集, 然后再按照前7后4划分分量数据

2.2 设置滑动窗口大小为7,制作数据集

# 定义滑动窗口大小

window_size = 7

# 分量划分分界

imf_no = 7

# 第一步,划分数据集

dataset1, dataset2 = make_wind_dataset(wind_emd_imfs, imf_no)

# 第二步,制作数据集标签 滑动窗口

# BiLSTM-Attention 模型数据

train_set1, train_label1 = data_window_maker(dataset1[0], window_size)

test_set1, test_label1 = data_window_maker(dataset1[1], window_size)

# ARIMA 模型数据

train_data_arima = dataset2[0]

test_data_arima = dataset2[1]

# 保存数据

dump(train_set1, 'train_set1')

dump(train_label1, 'train_label1')

dump(test_set1, 'test_set1')

dump(test_label1, 'test_label1')

dump(train_data_arima, 'train_data_arima')

dump(test_data_arima, 'test_data_arima')

分批保存数据,用于不同模型的预测

3 基于CEEMADN的BiLSTM-Attention模型预测

3.1 数据加载,训练数据、测试数据分组,数据分batch

# 加载数据

import torch

from joblib import dump, load

import torch.utils.data as Data

import numpy as np

import pandas as pd

import torch

import torch.nn as nn

# 参数与配置

torch.manual_seed(100) # 设置随机种子,以使实验结果具有可重复性

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载数据集

def dataloader(batch_size, workers=2):

# 训练集

train_set = load('train_set1')

train_label = load('train_label1')

# 测试集

test_set = load('test_set1')

test_label = load('test_label1')

# 加载数据

train_loader = Data.DataLoader(dataset=Data.TensorDataset(train_set, train_label),

batch_size=batch_size, num_workers=workers, drop_last=True)

test_loader = Data.DataLoader(dataset=Data.TensorDataset(test_set, test_label),

batch_size=batch_size, num_workers=workers, drop_last=True)

return train_loader, test_loader

batch_size = 64

# 加载数据

train_loader, test_loader = dataloader(batch_size)3.2 定义CEEMDAN-BiLSTM-Attention预测模型

注意:输入风速数据形状为 [64, 7, 7], batch_size=64, 维度7维代表7个分量,7代表序列长度(滑动窗口取值)。

3.3 定义模型参数

# 定义模型参数

batch_size = 64

input_len = 48 # 输入序列长度为96 (窗口值)

input_dim = 7 # 输入维度为7个分量

hidden_layer_sizes = [32, 64] # LSTM 层 结构 隐藏层神经元个数

attention_dim = hidden_layer_sizes[-1] # 注意力层维度 默认为 LSTM输出层维度

output_size = 1 # 单步输出

model = BiLSTMAttentionModel(batch_size, input_len, input_dim, attention_dim, hidden_layer_sizes, output_size=1)

# 定义损失函数和优化函数

model = model.to(device)

loss_function = nn.MSELoss() # loss

learn_rate = 0.003

optimizer = torch.optim.Adam(model.parameters(), learn_rate) # 优化器3.4 模型训练

训练结果

100个epoch,MSE 为0.00559,BiLSTM-Attention预测效果良好,适当调整模型参数,还可以进一步提高模型预测表现。

注意调整参数:

-

可以适当增加BiLSTM层数和隐藏层的维度,微调学习率;

-

调整注意力维度数,增加更多的 epoch (注意防止过拟合)

-

可以改变滑动窗口长度(设置合适的窗口长度)

保存训练结果和预测数据,以便和后面ARIMA模型的结果相组合。

4 基于ARIMA的模型预测

传统时序模型(ARIMA等模型)教程如下:

时序预测:LSTM、ARIMA、Holt-Winters、SARIMA模型的分析与比较-程序员宅基地

4.1 数据加载,训练数据、测试数据分组,四个分量,划分四个数据集

# 加载数据

from joblib import dump, load

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import matplotlib

matplotlib.rc("font", family='Microsoft YaHei')

# 训练集

train_set = load('train_data_arima')

# 测试集

test_set = load('test_data_arima')

# IMF1-Model1

model1_train = train_set[0, :]

model1_test = test_set[0, :]

# IMF2-Model2

model2_train = train_set[1, :]

model2_test = test_set[1, :]

# IMF3-Model3

model3_train = train_set[2, :]

model3_test = test_set[2, :]

# IMF4-Model4

model4_train = train_set[3, :]

model4_test = test_set[3, :]4.2 介绍一个分量预测过程(其他分量类似)

第一步,单位根检验和差分处理

ADF检验P值远小于0.05,故拒绝原假设,即数据是平稳的时间序列数据,也确定了d=0

第二步,模型识别,采用AIC指标进行参数选择

采用AIC指标进行参数选择,得到最小的AIC值的组合为p=2,q=0,选择其作为模型进行拟合,因此针对原数据可知最终确定模型为ARIMA(2,0,0)(结合代码指标结果来看)

第三步,模型预测

第四步,模型评估

保存预测的数据,其他分量预测与上述过程一致,保留最后模型结果即可。

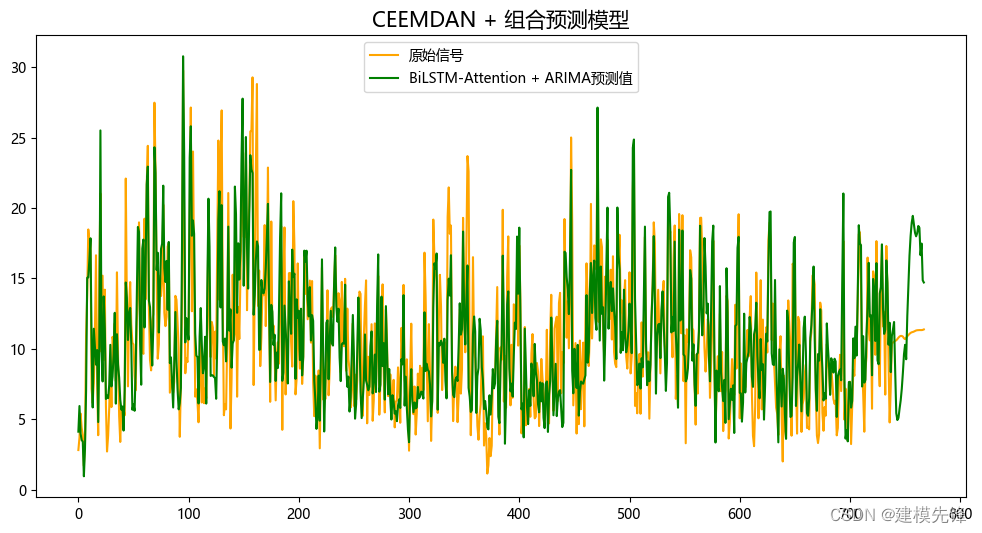

5 结果可视化和模型评估

5.1 组合预测,加载各模型的预测结果

# 训练集

arima_train_set = load('train_data_arima')

# 测试集

arima_test_set = load('test_data_arima')

# IMF1-Model1

model1_imf_arima_pre = load('model1_imf_arima_pre')

# IMF2-Model2

model2_imf_arima_pre = load('model2_imf_arima_pre')

# IMF3-Model3

model3_imf_arima_pre = load('model3_imf_arima_pre')

# IMF4-Model4

model4_imf_arima_pre = load('model4_imf_arima_pre')

# BiLSTM-Attention

original_label_bilstmatt = load('original_label_bilstmatt')

pre_data_bilstmatt = load('pre_data_bilstmatt')5.2 结果可视化

5.3 模型评估

由分量预测结果可见,前7个分量在BiLSTM-Attention预测模型下拟合效果良好,分量9在ARIMA模型的预测下,拟合程度比较好,其他低频分量拟合效果弱一点,调整参数可增强拟合效果。

代码、数据如下:

对数据集和代码感兴趣的,可以关注最后一行

# 加载数据

import torch

from joblib import dump, load

import torch.utils.data as Data

import numpy as np

import pandas as pd

import torch

import torch.nn as nn

# 参数与配置

torch.manual_seed(100) # 设置随机种子,以使实验结果具有可重复性

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

#代码和数据集:https://mbd.pub/o/bread/ZZiam5lx

智能推荐

生活垃圾数据集(YOLO版)_垃圾回收数据集-程序员宅基地

文章浏览阅读1.6k次,点赞5次,收藏20次。【有害垃圾】:电池(1 号、2 号、5 号)、过期药品或内包装等;【可回收垃圾】:易拉罐、小号矿泉水瓶;【厨余垃圾】:小土豆、切过的白萝卜、胡萝卜,尺寸为电池大小;【其他垃圾】:瓷片、鹅卵石(小土豆大小)、砖块等。文件结构|----classes.txt # 标签种类|----data-txt\ # 数据集文件集合|----images\ # 数据集图片|----labels\ # yolo标签。_垃圾回收数据集

天气系统3------微服务_cityid=101280803-程序员宅基地

文章浏览阅读272次。之前写到 通过封装的API 已经可以做到使用redis进行缓存天气信息但是这一操作每次都由客户使用时才进行更新 不友好 所以应该自己实现半小时的定时存入redis 使用quartz框架 首先添加依赖build.gradle中// Quartz compile('org.springframework.boot:spring-boot-starter-quartz'..._cityid=101280803

python wxpython 不同Frame 之间的参数传递_wxpython frame.bind-程序员宅基地

文章浏览阅读1.8k次,点赞2次,收藏8次。对于使用触发事件来反应的按钮传递参数如下:可以通过lambda对function的参数传递:t.Bind(wx.EVT_BUTTON, lambda x, textctrl=t: self.input_fun(event=x, textctrl=textctrl))前提需要self.input_fun(self,event,t):传入参数而同时两个Frame之间的参数传..._wxpython frame.bind

cocos小游戏开发总结-程序员宅基地

文章浏览阅读1.9k次。最近接到一个任务要开发消消乐小游戏,当然首先就想到乐cocosCreator来作为开发工具。开发本身倒没有多少难点。消消乐的开发官网发行的书上有专门讲到。下面主要总结一下开发中遇到的问题以及解决方法屏幕适配由于设计尺寸是750*1336,如果适应高度,则在iphonX下,内容会超出屏幕宽度。按宽适应,iphon4下内容会超出屏幕高度。所以就需要根据屏幕比例来动态设置适配策略。 onLoad..._750*1336

ssm435银行贷款管理系统+vue_vue3重构信贷管理系统-程序员宅基地

文章浏览阅读745次,点赞21次,收藏21次。web项目的框架,通常更简单的数据源。21世纪的今天,随着社会的不断发展与进步,人们对于信息科学化的认识,已由低层次向高层次发展,由原来的感性认识向理性认识提高,管理工作的重要性已逐渐被人们所认识,科学化的管理,使信息存储达到准确、快速、完善,并能提高工作管理效率,促进其发展。论文主要是对银行贷款管理系统进行了介绍,包括研究的现状,还有涉及的开发背景,然后还对系统的设计目标进行了论述,还有系统的需求,以及整个的设计方案,对系统的设计以及实现,也都论述的比较细致,最后对银行贷款管理系统进行了一些具体测试。_vue3重构信贷管理系统

乌龟棋 题解-程序员宅基地

文章浏览阅读774次。题目描述原题目戳这里小明过生日的时候,爸爸送给他一副乌龟棋当作礼物。乌龟棋的棋盘是一行 NNN 个格子,每个格子上一个分数(非负整数)。棋盘第 111 格是唯一的起点,第 NNN 格是终点,游戏要求玩家控制一个乌龟棋子从起点出发走到终点。乌龟棋中 MMM 张爬行卡片,分成 444 种不同的类型( MMM 张卡片中不一定包含所有 444 种类型的卡片,见样例),每种类型的卡片上分别标有 1,2,3,41, 2, 3, 41,2,3,4 四个数字之一,表示使用这种卡片后,乌龟棋子将向前爬行相应的格子数

随便推点

python内存泄露的原因_Python服务端内存泄露的处理过程-程序员宅基地

文章浏览阅读1.5k次。吐槽内存泄露 ? 内存暴涨 ? OOM ?首先提一下我自己曾经历过多次内存泄露,到底有几次? 我自己心里悲伤的回想了下,造成线上影响的内存泄露事件有将近5次了,没上线就查出内存暴涨次数可能更多。这次不是最惨,相信也不会是最后的内存的泄露。有人说,内存泄露对于程序员来说,是个好事,也是个坏事。 怎么说? 好事在于,技术又有所长进,经验有所心得…. 毕竟不是所有程序员都写过OOM的服务…. 坏事..._python内存泄露

Sensor (draft)_draft sensor-程序员宅基地

文章浏览阅读747次。1.sensor typeTYPE_ACCELEROMETER=1 TYPE_MAGNETIC_FIELD=2 (what's value mean at x and z axis)TYPE_ORIENTATION=3TYPE_GYROSCOPE=4 TYPE_LIGHT=5(in )TYPE_PRESSURE=6TYPE_TEMPERATURE=7TYPE_PRO_draft sensor

【刘庆源码共享】稀疏线性系统求解算法MGMRES(m) 之 矩阵类定义三(C++)_gmres不构造矩阵-程序员宅基地

文章浏览阅读581次。/* * Copyright (c) 2009 湖南师范大学数计院 一心飞翔项目组 * All Right Reserved * * 文件名:matrix.cpp 定义Point、Node、Matrix类的各个方法 * 摘 要:定义矩阵类,包括矩阵的相关信息和方法 * * 作 者:刘 庆 * 修改日期:2009年7月19日21:15:12 **/

三分钟带你看完HTML5增强的【iframe元素】_iframe allow-top-navigation-程序员宅基地

文章浏览阅读1.7w次,点赞6次,收藏20次。HTML不再推荐页面中使用框架集,因此HTML5删除了<frameset>、<frame>和<noframes>这三个元素。不过HTML5还保留了<iframe>元素,该元素可以在普通的HTML页面中使用,生成一个行内框架,可以直接放在HTML页面的任意位置。除了指定id、class和style之外,还可以指定如下属性:src 指定一个UR..._iframe allow-top-navigation

Java之 Spring Cloud 微服务的链路追踪 Sleuth 和 Zipkin(第三个阶段)【三】【SpringBoot项目实现商品服务器端是调用】-程序员宅基地

文章浏览阅读785次,点赞29次,收藏12次。Zipkin 是 Twitter 的一个开源项目,它基于 Google Dapper 实现,它致力于收集服务的定时数据,以解决微服务架构中的延迟问题,包括数据的收集、存储、查找和展现。我们可以使用它来收集各个服务器上请求链路的跟踪数据,并通过它提供的 REST API 接口来辅助我们查询跟踪数据以实现对分布式系统的监控程序,从而及时地发现系统中出现的延迟升高问题并找出系统性能瓶颈的根源。除了面向开发的 API 接口之外,它也提供了方便的 UI 组件来帮助我们直观的搜索跟踪信息和分析请求链路明细,

烁博科技|浅谈视频安全监控行业发展_2018年8月由于某知名视频监控厂商多款摄像机存在安全漏洞-程序员宅基地

文章浏览阅读358次。“随着天网工程的建设,中国已经建成世界上规模最大的视频监控网,摄像头总 数超过2000万个,成为世界上最安全的国家。视频图像及配套数据已经应用在反恐维稳、治安防控、侦查破案、交通行政管理、服务民生等各行业各领域。烁博科技视频安全核心能力:精准智能数据采集能力:在建设之初即以应用需求为导向,开展点位选择、设备选型等布建工作,实现前端采集设备的精细化部署。随需而动的AI数据挖掘能力:让AI所需要的算力、算法、数据、服务都在应用需求的牵引下实现合理的调度,实现解析能力的最大化。完善的数据治理能力:面_2018年8月由于某知名视频监控厂商多款摄像机存在安全漏洞