Windows下使用QT+OpenCV完成人脸检测(获取摄像头的数据进行检测)_qtopencv人脸检测-程序员宅基地

一、环境介绍

Windows版本: Win10 X64

OpenCV版本: 2.4.13.6

QT版本: 5.12

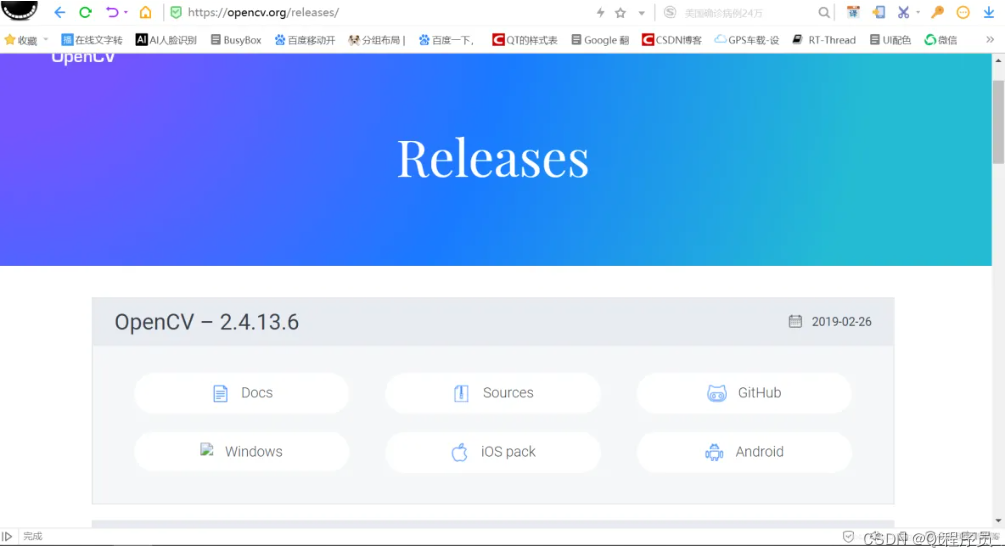

二、OpenCV库下载

OpenCV官网下载地址: https://opencv.org

目前官网OpenCV最新的版本是4.2.0 ,Windows版本的OpenCV在3.X版本后就不带X86的库,只有X64的库,如果需要X86的库,需要自己下载源码去重新编译。

由于我的QT软件在安装时没有安装64位的编译器,又不想重新安装64位编译器,就选择了2.X的版本完成开发测试,3.X的版本在添加库的时候非常方便,就一个库。

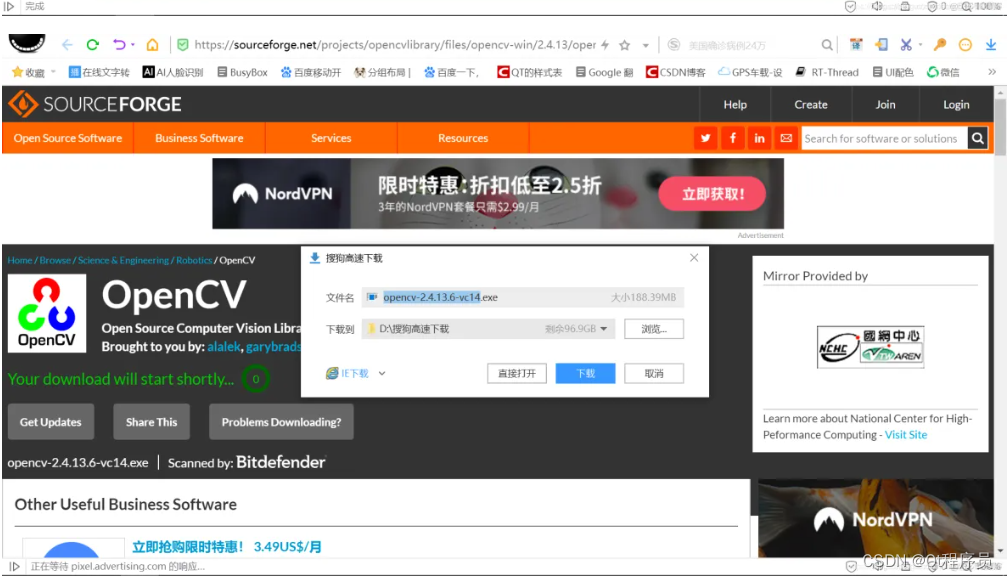

库下载之后,双击运行,解压到指定的目录就行。

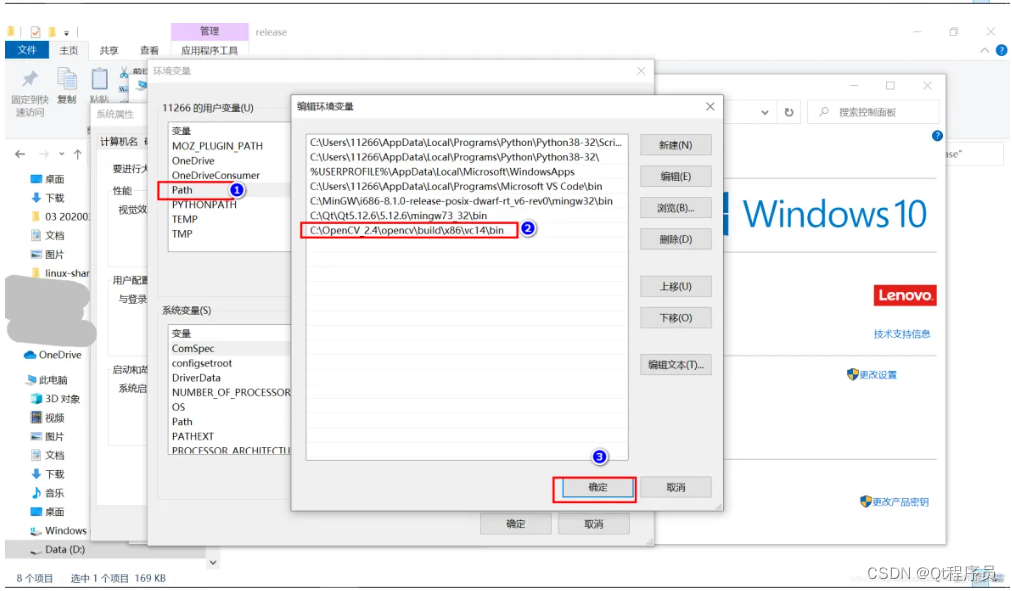

接下来要把OpenCV的动态库目录加到系统环境变量里,否则程序运行时找不到依赖库会崩溃。

三、程序思路说明

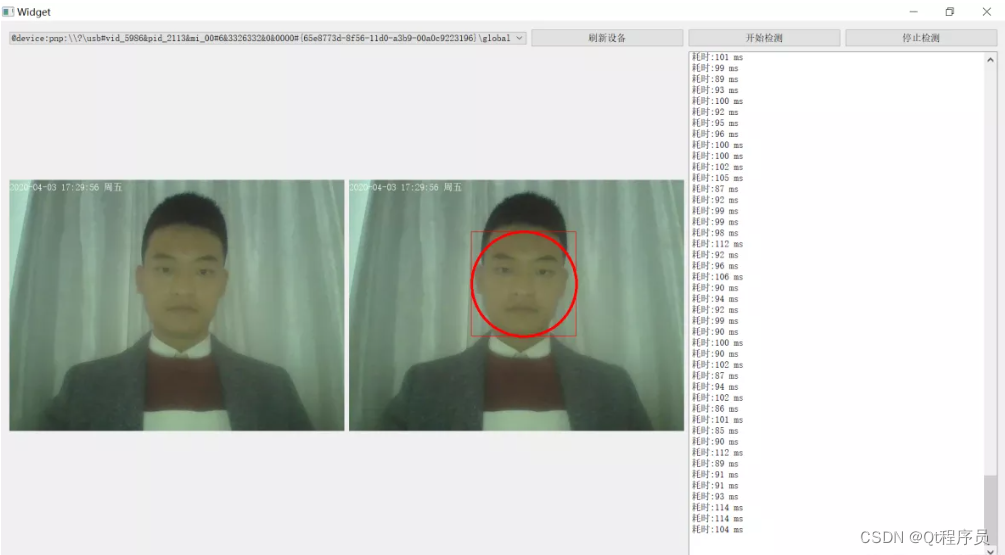

程序功能: 在子线程里打开摄像头,获取摄像头的数据,通过信号与槽的方式,将摄像头数据传递给主UI界面实时显示,在采用定时器每100ms取一次标签上的数据进行人脸检测处理,将处理的数据再显示到另一个标签上。人脸检测分类器采用OpenCV自带的分类器,程序主要目的是介绍OpenCV配合QT如何进行开发。

OpenCV自带的人脸检测分类器路径:C:/OpenCV_2.4/opencv/sources/data/haarcascades_GPU/haarcascade_frontalface_alt2.xml

四、实现效果

五、核心代码

xxx.pro工程文件代码:

QT += core gui

QT += multimediawidgets

QT += xml

QT += multimedia

QT += network

QT += widgets

QT += serialport

greaterThan(QT_MAJOR_VERSION, 4): QT += widgets

CONFIG += c++11

# The following define makes your compiler emit warnings if you use

# any Qt feature that has been marked deprecated (the exact warnings

# depend on your compiler). Please consult the documentation of the

# deprecated API in order to know how to port your code away from it.

DEFINES += QT_DEPRECATED_WARNINGS

# You can also make your code fail to compile if it uses deprecated APIs.

# In order to do so, uncomment the following line.

# You can also select to disable deprecated APIs only up to a certain version of Qt.

#DEFINES += QT_DISABLE_DEPRECATED_BEFORE=0x060000 # disables all the APIs deprecated before Qt 6.0.0

SOURCES += \

main.cpp \

widget.cpp

HEADERS += \

widget.h

FORMS += \

widget.ui

# Default rules for deployment.

qnx: target.path = /tmp/$${TARGET}/bin

else: unix:!android: target.path = /opt/$${TARGET}/bin

!isEmpty(target.path): INSTALLS += target

#linu平台的路径设置

linux {

message('运行linu版本')

#添加opencv头文件的路径,需要根据自己的头文件路径进行修改

INCLUDEPATH+=/home/wbyq/work_pc/opencv-3.4.9/_install/install/include\

/home/wbyq/work_pc/opencv-3.4.9/_install/install/include/opencv\

/home/wbyq/work_pc/opencv-3.4.9/_install/install/include/opencv2

LIBS+=/home/wbyq/work_pc/opencv-3.4.9/_install/install/lib/libopencv_*

}

win32

{

message('运行win32版本')

#添加opencv头文件的路径,需要根据自己的头文件路径进行修改

INCLUDEPATH+=C:/OpenCV_2.4/opencv/build/include \

C:/OpenCV_2.4/opencv/build/include/opencv \

C:/OpenCV_2.4/opencv/build/include/opencv2

LIBS+=C:/OpenCV_2.4/opencv/build/x86/vc14/lib/opencv_*

}

RESOURCES += \

image.qrcwidget.cpp文件代码:

#include "widget.h"

#include "ui_widget.h"

class VideoAudioEncode videoaudioencode_0;

Widget::Widget(QWidget *parent)

: QWidget(parent)

, ui(new Ui::Widget)

{

ui->setupUi(this);

//驾驶室摄像头

//工作对象

videoRead_WorkClass_0=new VideoReadThread_0;

videoRead_Workthread_0=new QThread;

//连接摄像头采集信号,在主线程实时显示视频画面

connect(videoRead_WorkClass_0,SIGNAL(VideoDataOutput(QImage )),this,SLOT(VideoDataDisplay_0(QImage )));

//摄像头初始化函数

connect(this,SIGNAL(Init_VideoAudio_WorkClass_0()),videoRead_WorkClass_0,SLOT(run()));

//停止视频采集

connect(this,SIGNAL(Stop_AudioVideo0_work_0()),videoRead_WorkClass_0,SLOT(stop()));

//将工作对象移动到子线程里工作

videoRead_WorkClass_0->moveToThread(videoRead_Workthread_0);

//更新设备列表

UpdateVideoAudiodDevice(ui->comboBox_video_0,ui->plainTextEdit_log_0);

//

timer.start(100);

connect(&timer,SIGNAL(timeout()), this, SLOT(update()));

timer.start(100);

}

Widget::~Widget()

{

delete ui;

}

//分类器的路径

#define source_xml_addr "C:/OpenCV_2.4/opencv/sources/data/haarcascades_GPU/haarcascade_frontalface_alt2.xml"

//将要检测的图片路径

#define source_pix_addr "D:/linux-share-dir/1.jpg"

//人脸检测代码

void Widget::opencv_face(QImage qImage)

{

QTime time;

time.start();

static CvMemStorage* storage = 0;

static CvHaarClassifierCascade* cascade = 0;

const char*cascade_name =source_xml_addr;

//加载分类器

cascade = (CvHaarClassifierCascade*)cvLoad( cascade_name, 0, 0, 0 );

if( !cascade )

{

Log_Display_0("分类器加载错误.\n");

return ;

}

//创建内存空间

storage = cvCreateMemStorage(0);

//加载需要检测的图片

//const char* filename =source_pix_addr;

//IplImage* img = cvLoadImage(filename, 1 );

IplImage* img = QImageToIplImage(&qImage);

if(img ==nullptr )

{

Log_Display_0("图片加载错误.\n");

return;

}

double scale=1.2;

static CvScalar colors[] = {

{

{0,0,255}},{

{0,128,255}},{

{0,255,255}},{

{0,255,0}},

{

{255,128,0}},{

{255,255,0}},{

{255,0,0}},{

{255,0,255}}

};//Just some pretty colors to draw with

IplImage* gray = cvCreateImage(cvSize(img->width,img->height),8,1);

IplImage* small_img=cvCreateImage(cvSize(cvRound(img->width/scale),cvRound(img->height/scale)),8,1);

cvCvtColor(img,gray, CV_BGR2GRAY);

cvResize(gray, small_img, CV_INTER_LINEAR);

cvEqualizeHist(small_img,small_img); //直方图均衡

cvClearMemStorage(storage);

double t = (double)cvGetTickCount();

CvSeq* objects = cvHaarDetectObjects(small_img,

cascade,

storage,

1.1,

2,

0/*CV_HAAR_DO_CANNY_PRUNING*/,

cvSize(30,30));

t = (double)cvGetTickCount() - t;

//遍历找到对象和周围画盒

for(int i=0;i<(objects->total);++i)

{

CvRect* r=(CvRect*)cvGetSeqElem(objects,i);

cvRectangle(img, cvPoint(r->x*scale,r->y*scale), cvPoint((r->x+r->width)*scale,(r->y+r->height)*scale), colors[i%8]);

}

for( int i = 0; i < (objects? objects->total : 0); i++ )

{

CvRect* r = (CvRect*)cvGetSeqElem( objects, i );

CvPoint center;

int radius;

center.x = cvRound((r->x + r->width*0.5)*scale);

center.y = cvRound((r->y + r->height*0.5)*scale);

radius = cvRound((r->width + r->height)*0.25*scale);

cvCircle(img, center, radius, colors[i%8], 3, 8, 0 );

}

show_face(img); //显示检测的结果

cvReleaseImage(&gray);

cvReleaseImage(&small_img);

//释放图片

cvReleaseImage(&img);

Log_Display_0(tr("耗时:%1 ms\n").arg(time.elapsed()));

}

/*将QImage图片转为opecv的qimage格式*/

IplImage *Widget::QImageToIplImage(const QImage * qImage)

{

int width = qImage->width();

int height = qImage->height();

CvSize Size;

Size.height = height;

Size.width = width;

IplImage *IplImageBuffer = cvCreateImage(Size, IPL_DEPTH_8U, 3);

for (int y = 0; y < height; ++y)

{

for (int x = 0; x < width; ++x)

{

QRgb rgb = qImage->pixel(x, y);

CV_IMAGE_ELEM( IplImageBuffer, uchar, y, x*3+0 ) = qBlue(rgb);

CV_IMAGE_ELEM( IplImageBuffer, uchar, y, x*3+1 ) = qGreen(rgb);

CV_IMAGE_ELEM( IplImageBuffer, uchar, y, x*3+2 ) = qRed(rgb);

}

}

return IplImageBuffer;

}

/*将opecv的图片转为qimage格式*/

QImage *Widget::IplImageToQImage(IplImage *img)

{

QImage *qmg;

uchar *imgData=(uchar *)img->imageData;

qmg = new QImage(imgData,img->width,img->height,QImage::Format_RGB888);

*qmg=qmg->rgbSwapped(); //BGR格式转RGB

return qmg;

}

//显示检测的结果

void Widget::show_face(IplImage* img)

{

uchar *imgData=(uchar *)img->imageData;

QImage my_image=QImage(imgData,img->width,img->height,QImage::Format_RGB888);

my_image=my_image.rgbSwapped(); //BGR格式转RGB

QPixmap my_pix; //创建画图类

my_pix.convertFromImage(my_image);

/*在控件上显示*/

ui->label_display->setPixmap(my_pix);

}

//开始采集

void Widget::on_pushButton_Start_clicked()

{

//设置当前选择的摄像头

videoaudioencode_0.camera=video_dev_list.at(ui->comboBox_video_0->currentIndex());

Stop_VideoAudioEncode_0(true);

Start_VideoAudioEncode_Thread_0();

}

//析构函数

VideoReadThread_0::~VideoReadThread_0()

{

}

//停止视频采集

void VideoReadThread_0::stop()

{

qDebug()<<"停止视频采集--stop";

if(camera)

{

camera->stop();

delete camera;

camera=nullptr;

}

if(m_pProbe)

{

delete m_pProbe;

m_pProbe=nullptr;

}

}

//执行线程

void VideoReadThread_0::run()

{

stop();

Camear_Init();

qDebug()<<"摄像头开始采集数据";

}

void VideoReadThread_0::Camear_Init()

{

/*创建摄像头对象,根据选择的摄像头打开*/

camera = new QCamera(videoaudioencode_0.camera);

m_pProbe = new QVideoProbe;

if(m_pProbe != nullptr)

{

m_pProbe->setSource(camera); // Returns true, hopefully.

connect(m_pProbe, SIGNAL(videoFrameProbed(QVideoFrame)),this, SLOT(slotOnProbeFrame(QVideoFrame)), Qt::QueuedConnection);

}

/*配置摄像头捕 QCamera *camera;

QVideoProbe *m_pProbe;获模式为帧捕获模式*/

//camera->setCaptureMode(QCamera::CaptureStillImage); //如果在Linux系统下运行就这样设置

camera->setCaptureMode(QCamera::CaptureVideo);//如果在android系统下运行就这样设置

/*启动摄像头*/

camera->start();

/*设置摄像头的采集帧率和分辨率*/

QCameraViewfinderSettings settings;

settings.setPixelFormat(QVideoFrame::Format_YUYV); //设置像素格式 Android上只支持NV21格式

settings.setResolution(QSize(VIDEO_WIDTH,VIDEO_HEIGHT)); //设置摄像头的分辨率

camera->setViewfinderSettings(settings);

}

/**

* NV21是android相机默认格式

* @param data

* @param rgb

* @param width

* @param height

*/

void NV21_TO_RGB24(unsigned char *yuyv, unsigned char *rgb, int width, int height)

{

const int nv_start = width * height ;

int index = 0, rgb_index = 0;

uint8_t y, u, v;

int r, g, b, nv_index = 0,i, j;

for(i = 0; i < height; i++){

for(j = 0; j < width; j ++){

//nv_index = (rgb_index / 2 - width / 2 * ((i + 1) / 2)) * 2;

nv_index = i / 2 * width + j - j % 2;

y = yuyv[rgb_index];

u = yuyv[nv_start + nv_index ];

v = yuyv[nv_start + nv_index + 1];

r = y + (140 * (v-128))/100; //r

g = y - (34 * (u-128))/100 - (71 * (v-128))/100; //g

b = y + (177 * (u-128))/100; //b

if(r > 255) r = 255;

if(g > 255) g = 255;

if(b > 255) b = 255;

if(r < 0) r = 0;

if(g < 0) g = 0;

if(b < 0) b = 0;

index = rgb_index % width + (height - i - 1) * width;

//rgb[index * 3+0] = b;

//rgb[index * 3+1] = g;

//rgb[index * 3+2] = r;

//颠倒图像

//rgb[height * width * 3 - i * width * 3 - 3 * j - 1] = b;

//rgb[height * width * 3 - i * width * 3 - 3 * j - 2] = g;

//rgb[height * width * 3 - i * width * 3 - 3 * j - 3] = r;

//正面图像

rgb[i * width * 3 + 3 * j + 0] = b;

rgb[i * width * 3 + 3 * j + 1] = g;

rgb[i * width * 3 + 3 * j + 2] = r;

rgb_index++;

}

}

}

/*

函数功能: 将YUV数据转为RGB格式

函数参数:

unsigned char *yuv_buffer: YUV源数据

unsigned char *rgb_buffer: 转换之后的RGB数据

int iWidth,int iHeight : 图像的宽度和高度

*/

void yuyv_to_rgb(unsigned char *yuv_buffer,unsigned char *rgb_buffer,int iWidth,int iHeight)

{

int x;

int z=0;

unsigned char *ptr = rgb_buffer;

unsigned char *yuyv= yuv_buffer;

for (x = 0; x < iWidth*iHeight; x++)

{

int r, g, b;

int y, u, v;

if (!z)

y = yuyv[0] << 8;

else

y = yuyv[2] << 8;

u = yuyv[1] - 128;

v = yuyv[3] - 128;

r = (y + (359 * v)) >> 8;

g = (y - (88 * u) - (183 * v)) >> 8;

b = (y + (454 * u)) >> 8;

*(ptr++) = (r > 255) ? 255 : ((r < 0) ? 0 : r);

*(ptr++) = (g > 255) ? 255 : ((g < 0) ? 0 : g);

*(ptr++) = (b > 255) ? 255 : ((b < 0) ? 0 : b);

if(z++)

{

z = 0;

yuyv += 4;

}

}

}

void VideoReadThread_0::slotOnProbeFrame(const QVideoFrame &frame)

{

QVideoFrame cloneFrame(frame);

cloneFrame.map(QAbstractVideoBuffer::ReadOnly);

//qDebug()<<"height:"<<cloneFrame.height();

//qDebug()<<"width:"<<cloneFrame.width();

//qDebug()<<"bytesPerLine:"<<cloneFrame.bytesPerLine();

//qDebug()<<"mappedBytes:"<<cloneFrame.mappedBytes();

//qDebug()<<"pixelFormat:"<<cloneFrame.pixelFormat();

unsigned char rgb_buffer[VIDEO_WIDTH*VIDEO_HEIGHT*3];

if(cloneFrame.pixelFormat()==QVideoFrame::Format_NV21)

{

NV21_TO_RGB24(cloneFrame.bits(),rgb_buffer,cloneFrame.width(),cloneFrame.height());

}

else if(cloneFrame.pixelFormat()==QVideoFrame::Format_YUYV)

{

yuyv_to_rgb(cloneFrame.bits(),rgb_buffer,cloneFrame.width(),cloneFrame.height());

}

else

{

qDebug("当前格式编码为%1,暂时不支持转换.\n");

}

cloneFrame.unmap();

//加载图片数据

QImage image(rgb_buffer,

cloneFrame.width(),

cloneFrame.height(),

QImage::Format_RGB888);

//绘制图片水印

QDateTime dateTime(QDateTime::currentDateTime());

//时间效果: 2020-03-05 16:25::04 周一

QString qStr="";

qStr+=dateTime.toString("yyyy-MM-dd hh:mm:ss ddd");

QPainter pp(&image);

QPen pen = QPen(Qt::white);

pp.setPen(pen);

pp.drawText(QPointF(0,20),qStr);

//提取RGB数据

unsigned char *p=rgb_buffer;

for(int i=0;i<image.height();i++)

{

for(int j=0;j<image.width();j++)

{

QRgb rgb=image.pixel(j,i);

*p++=qRed(rgb);

*p++=qGreen(rgb);

*p++=qBlue(rgb);

}

}

emit VideoDataOutput(image); //发送信号

}

//驾驶室:视频刷新显示

void Widget::VideoDataDisplay_0(QImage image)

{

QPixmap my_pixmap;

my_pixmap.convertFromImage(image);

/*在控件上显示*/

ui->label_ImageDisplay_0->setPixmap(my_pixmap);

}

//驾驶室:日志显示

void Widget::Log_Display_0(QString text)

{

Log_Text_Display(ui->plainTextEdit_log_0,text);

}

/*日志显示*/

void Widget::Log_Text_Display(QPlainTextEdit *plainTextEdit_log,QString text)

{

plainTextEdit_log->insertPlainText(text);

//移动滚动条到底部

QScrollBar *scrollbar = plainTextEdit_log->verticalScrollBar();

if(scrollbar)

{

scrollbar->setSliderPosition(scrollbar->maximum());

}

}

//驾驶室:开启所有采集线程

void Widget::Start_VideoAudioEncode_Thread_0()

{

videoRead_Workthread_0->start(); //开启视频采集线程

Init_VideoAudio_WorkClass_0(); //发送初始化信号

}

//驾驶室:退出所有采集线程

void Widget::Stop_VideoAudioEncode_0(bool flag)

{

if(flag==true)

{

Stop_AudioVideo0_work_0(); //发送信号停止摄像头

QThread::msleep(10);

//退出视频采集

videoRead_Workthread_0->quit(); //告诉线程的事件循环以return 0(成功)退出

videoRead_Workthread_0->wait(); //等待线程退出

}

}

void Widget::on_pushButton_update_clicked()

{

UpdateVideoAudiodDevice(ui->comboBox_video_0,ui->plainTextEdit_log_0);

}

/*刷新本机可以的音频设备列表*/

void Widget::UpdateVideoAudiodDevice(

QComboBox *comboBox_video,

QPlainTextEdit *plainTextEdit_log)

{

/*2. 获取摄像头列表*/

video_dev_list.clear();

comboBox_video->clear();

video_dev_list=QCameraInfo::availableCameras();

for(int i=0;i<video_dev_list.size();i++)

{

comboBox_video->addItem(video_dev_list.at(i).deviceName());

}

/*如果没有可用的摄像头设备,按钮不可用*/

if(video_dev_list.size()==0)

{

Log_Text_Display(plainTextEdit_log,"未查询到可用的摄像头设备.\n");

}

}

//停止采集

void Widget::on_pushButton_stop_clicked()

{

Stop_VideoAudioEncode_0(true);

}

void Widget::update()

{

if(ui->label_ImageDisplay_0->pixmap())

opencv_face(ui->label_ImageDisplay_0->pixmap()->toImage());

}widget.h文件代码:

#ifndef WIDGET_H

#define WIDGET_H

#include <QWidget>

//opencv include

#include <cv.h>

#include <cxcore.h>

#include <highgui.h>

#include <QCamera>

#include <QVideoProbe>

#include <QAbstractVideoSurface>

#include <QVideoProbe>

#include <QThread>

#include <QApplication>

#include <QDebug>

#include <QObject>

#include <QMutex>

#include <QMutexLocker>

#include <QWaitCondition>

#include <QQueue>

#include <QCamera>

#include <QPen>

#include <QPainter>

#include <QRgb>

#include <QDateTime>

#include <QCameraInfo>

#include <QPlainTextEdit>

#include <QScrollBar>

#include <QComboBox>

#include <QTimer>

QT_BEGIN_NAMESPACE

namespace Ui { class Widget; }

QT_END_NAMESPACE

class Widget : public QWidget

{

Q_OBJECT

public:

Widget(QWidget *parent = nullptr);

void opencv_face(QImage qImage);

~Widget();

QList<QCameraInfo> video_dev_list;

void show_face(IplImage* img);

class VideoReadThread_0 *videoRead_WorkClass_0; //视频工作类

QThread *videoRead_Workthread_0; //视频线程

/*驾驶室摄像头*/

void Stop_VideoAudioEncode_0(bool flag);//停止线程

void Start_VideoAudioEncode_Thread_0(); //启动线程

void Log_Text_Display(QPlainTextEdit *plainTextEdit_log,QString text);

void UpdateVideoAudiodDevice(QComboBox *comboBox_video, QPlainTextEdit *plainTextEdit_log);

IplImage *QImageToIplImage(const QImage * qImage);

QImage *IplImageToQImage(IplImage *img);

QTimer timer;

signals:

void Init_VideoAudio_WorkClass_0();

void Stop_AudioVideo0_work_0();

private slots:

void update();

void on_pushButton_Start_clicked();

void Log_Display_0(QString text);

void VideoDataDisplay_0(QImage );

void on_pushButton_update_clicked();

void on_pushButton_stop_clicked();

private:

Ui::Widget *ui;

};

class VideoReadThread_0:public QObject

{

Q_OBJECT

public:

QCamera *camera;

QVideoProbe *m_pProbe;

VideoReadThread_0(QObject* parent=nullptr):QObject(parent){camera=nullptr;m_pProbe=nullptr;}

~VideoReadThread_0();

void Camear_Init(void);

public slots:

void stop();

void run();

void slotOnProbeFrame(const QVideoFrame &frame);

signals:

void VideoDataOutput(QImage); //输出信号

};

//视频音频编码类

class VideoAudioEncode

{

public:

QCameraInfo camera; //当前选择的摄像头

};

//视频输出尺寸

#define VIDEO_WIDTH 640

#define VIDEO_HEIGHT 480

extern class VideoAudioEncode videoaudioencode_0;

#endif // WIDGET_Hmain.cpp文件代码:

#include "widget.h"

#include <QApplication>

int main(int argc, char *argv[])

{

QApplication a(argc, argv);

Widget w;

w.show();

return a.exec();

}UI界面文件:

进群领取qt开发学习资料以及技术交流 在下方↓↓↓↓↓↓↓↓

智能推荐

攻防世界_难度8_happy_puzzle_攻防世界困难模式攻略图文-程序员宅基地

文章浏览阅读645次。这个肯定是末尾的IDAT了,因为IDAT必须要满了才会开始一下个IDAT,这个明显就是末尾的IDAT了。,对应下面的create_head()代码。,对应下面的create_tail()代码。不要考虑爆破,我已经试了一下,太多情况了。题目来源:UNCTF。_攻防世界困难模式攻略图文

达梦数据库的导出(备份)、导入_达梦数据库导入导出-程序员宅基地

文章浏览阅读2.9k次,点赞3次,收藏10次。偶尔会用到,记录、分享。1. 数据库导出1.1 切换到dmdba用户su - dmdba1.2 进入达梦数据库安装路径的bin目录,执行导库操作 导出语句:./dexp cwy_init/[email protected]:5236 file=cwy_init.dmp log=cwy_init_exp.log 注释: cwy_init/init_123..._达梦数据库导入导出

js引入kindeditor富文本编辑器的使用_kindeditor.js-程序员宅基地

文章浏览阅读1.9k次。1. 在官网上下载KindEditor文件,可以删掉不需要要到的jsp,asp,asp.net和php文件夹。接着把文件夹放到项目文件目录下。2. 修改html文件,在页面引入js文件:<script type="text/javascript" src="./kindeditor/kindeditor-all.js"></script><script type="text/javascript" src="./kindeditor/lang/zh-CN.js"_kindeditor.js

STM32学习过程记录11——基于STM32G431CBU6硬件SPI+DMA的高效WS2812B控制方法-程序员宅基地

文章浏览阅读2.3k次,点赞6次,收藏14次。SPI的详情简介不必赘述。假设我们通过SPI发送0xAA,我们的数据线就会变为10101010,通过修改不同的内容,即可修改SPI中0和1的持续时间。比如0xF0即为前半周期为高电平,后半周期为低电平的状态。在SPI的通信模式中,CPHA配置会影响该实验,下图展示了不同采样位置的SPI时序图[1]。CPOL = 0,CPHA = 1:CLK空闲状态 = 低电平,数据在下降沿采样,并在上升沿移出CPOL = 0,CPHA = 0:CLK空闲状态 = 低电平,数据在上升沿采样,并在下降沿移出。_stm32g431cbu6

计算机网络-数据链路层_接收方收到链路层数据后,使用crc检验后,余数为0,说明链路层的传输时可靠传输-程序员宅基地

文章浏览阅读1.2k次,点赞2次,收藏8次。数据链路层习题自测问题1.数据链路(即逻辑链路)与链路(即物理链路)有何区别?“电路接通了”与”数据链路接通了”的区别何在?2.数据链路层中的链路控制包括哪些功能?试讨论数据链路层做成可靠的链路层有哪些优点和缺点。3.网络适配器的作用是什么?网络适配器工作在哪一层?4.数据链路层的三个基本问题(帧定界、透明传输和差错检测)为什么都必须加以解决?5.如果在数据链路层不进行帧定界,会发生什么问题?6.PPP协议的主要特点是什么?为什么PPP不使用帧的编号?PPP适用于什么情况?为什么PPP协议不_接收方收到链路层数据后,使用crc检验后,余数为0,说明链路层的传输时可靠传输

软件测试工程师移民加拿大_无证移民,未受过软件工程师的教育(第1部分)-程序员宅基地

文章浏览阅读587次。软件测试工程师移民加拿大 无证移民,未受过软件工程师的教育(第1部分) (Undocumented Immigrant With No Education to Software Engineer(Part 1))Before I start, I want you to please bear with me on the way I write, I have very little gen...

随便推点

Thinkpad X250 secure boot failed 启动失败问题解决_安装完系统提示secureboot failure-程序员宅基地

文章浏览阅读304次。Thinkpad X250笔记本电脑,装的是FreeBSD,进入BIOS修改虚拟化配置(其后可能是误设置了安全开机),保存退出后系统无法启动,显示:secure boot failed ,把自己惊出一身冷汗,因为这台笔记本刚好还没开始做备份.....根据错误提示,到bios里面去找相关配置,在Security里面找到了Secure Boot选项,发现果然被设置为Enabled,将其修改为Disabled ,再开机,终于正常启动了。_安装完系统提示secureboot failure

C++如何做字符串分割(5种方法)_c++ 字符串分割-程序员宅基地

文章浏览阅读10w+次,点赞93次,收藏352次。1、用strtok函数进行字符串分割原型: char *strtok(char *str, const char *delim);功能:分解字符串为一组字符串。参数说明:str为要分解的字符串,delim为分隔符字符串。返回值:从str开头开始的一个个被分割的串。当没有被分割的串时则返回NULL。其它:strtok函数线程不安全,可以使用strtok_r替代。示例://借助strtok实现split#include <string.h>#include <stdio.h&_c++ 字符串分割

2013第四届蓝桥杯 C/C++本科A组 真题答案解析_2013年第四届c a组蓝桥杯省赛真题解答-程序员宅基地

文章浏览阅读2.3k次。1 .高斯日记 大数学家高斯有个好习惯:无论如何都要记日记。他的日记有个与众不同的地方,他从不注明年月日,而是用一个整数代替,比如:4210后来人们知道,那个整数就是日期,它表示那一天是高斯出生后的第几天。这或许也是个好习惯,它时时刻刻提醒着主人:日子又过去一天,还有多少时光可以用于浪费呢?高斯出生于:1777年4月30日。在高斯发现的一个重要定理的日记_2013年第四届c a组蓝桥杯省赛真题解答

基于供需算法优化的核极限学习机(KELM)分类算法-程序员宅基地

文章浏览阅读851次,点赞17次,收藏22次。摘要:本文利用供需算法对核极限学习机(KELM)进行优化,并用于分类。

metasploitable2渗透测试_metasploitable2怎么进入-程序员宅基地

文章浏览阅读1.1k次。一、系统弱密码登录1、在kali上执行命令行telnet 192.168.26.1292、Login和password都输入msfadmin3、登录成功,进入系统4、测试如下:二、MySQL弱密码登录:1、在kali上执行mysql –h 192.168.26.129 –u root2、登录成功,进入MySQL系统3、测试效果:三、PostgreSQL弱密码登录1、在Kali上执行psql -h 192.168.26.129 –U post..._metasploitable2怎么进入

Python学习之路:从入门到精通的指南_python人工智能开发从入门到精通pdf-程序员宅基地

文章浏览阅读257次。本文将为初学者提供Python学习的详细指南,从Python的历史、基础语法和数据类型到面向对象编程、模块和库的使用。通过本文,您将能够掌握Python编程的核心概念,为今后的编程学习和实践打下坚实基础。_python人工智能开发从入门到精通pdf